超普通心理学/智力/人工智能

| 超普通心理学 |

|---|

| 心理学绪论 |

| 心理学研究法 |

| 行为的生理基础 |

| 感觉与知觉 |

| 感觉系统‧知觉系统 |

| 意识 |

| 睡眠‧梦 |

| 学习 |

| 记忆 |

| 感官记忆‧短期记忆‧工作记忆‧长期记忆 |

| 语言与思考 |

| 认知科学‧语言‧思考 |

| 智力 |

| 智力理论‧人工智能 |

| 发展心理学 |

| 动机与情绪 |

| 情绪的种类 |

| 压力与健康 |

| 性格 |

| 常见的人格障碍类型 |

| 心理异常 |

| 心理异常的治疗 |

| 社会心理学 |

| 社会认知、基模、归因、态度‧自我 |

人工智能 Artificial intelegence 定义:人工智能是打造电脑与机器的科学领域,这些电脑和机器可以进行推论、学习以及采取行动,而这类行动原本需要人类智能判断或涉及超出人为分析能力上限的数据规模。其广泛的版图,包含许多不同的专业领域,例如计算机科学、数据分析与统计数据、硬件与软件工程、数学、语言学、神经科学,甚至是哲学和心理学。虽然人工智能由人类编程,其所知也是人类多年的研究成果,但其对于信息的处理、解读与链接能力也远高于人类大脑的能力。

计算机科学将人工智能研究定义为对“智能代理人”的研究:任何能够感知其环境并采取行动最大化其成功实现目标的机制的设备。更详细的是,Kaplan和Haenlein将AI定义为“系统正确解释外部数据,从这些数据中学习,并通过灵活适应使用这些学习来实现特定目标和任务的能力。”通俗地说,当机器模仿人类与其他人类思维相关的“认知”功能时,应用“人工智能”这一术语,如“学习”和“解决问题”。

人工智能的范围存在争议:随着机器越来越强大,被认为需要“智能”的任务通常会被从定义中删除,这种现象称为AI效应。导致Tesler定理中的讽刺,“AI就是还没被完成的事”。例如:光学字符识别经常被排除在人工智能之外,已经成为一种常规技术。通常被归类为AI的现代机器功能包括成功地理解人类语音、在战略游戏系统中的最高级别难度、自主运行汽车,以及内容传递网络和军事模拟中的智能路由。

人工智能领域利用计算机科学、信息工程、数学、心理学、语言学、哲学等。该领域的基础是人类智能“可以如此精确地描述,可以使机器模拟它。”这引发了关于心灵本质的哲学论证以及创造具有类人智能的人造生物的伦理。这些问题是自古以来神话,小说和哲学所探讨的问题,有些人认为人工智能如果不断发展就会对人类构成威胁,另外,也有人认为,与以往的技术革命不同,人工智能会造成大规模失业的风险。

在二十一世纪,随着计算机能力,大数据和理论理解的同步发展,人工智能技术已经成为技术行业的重要组成部分,有助于解决计算机科学,软件工程和运筹学中的许多挑战性问题。

历史

[编辑]人工智能发展的历史可说是十年河东,十年河西,早期流行符号学派,也就是所谓的专家系统,询问专家其领域相关的知识,如询问医生怎么辨别流感及一般感冒?又或是问气象学家怎么预测天气状况?借由搜集到的信息将其导入数据库,提供给机器去判读。然此种方式在大量收集数据的情况下,可能出现规则冲突的情况,另外像向专家学习也存在经验、领域知识无法完整传递的问题,故晚近则是流行链接联结派,不同于符号学派采演绎推理的模式,联结派则是采用归纳推理,允许例外情况存在,并能进行自我学习。

人工智能的发展历史中的重要事件纪录如下表:

| 年代 | 人物 | 事件 |

|---|---|---|

| 17世纪初 | 笛卡儿(René Descartes) | 提出动物身体只不过是复杂的机器 |

| 1642 | 帕斯卡(Blaise Pascal) | 发明第一台机械数字计算机 |

| 19世纪 | 巴贝奇(Charles Babbage) | 提出与制作差分机、分析机 |

| 19世纪 | 勒芙蕾丝(Ada Lovelace) | 发表了第一段分析机的算法 |

| 1910 | 罗素(Bertrand Russell)

怀海德(Alfred North Whitehead) |

发表了Principia Mathematica,修改了形式逻辑 |

| 1943 | 麦卡洛克(Warren McCulloch)

皮茨(Walter Pitts) |

发表《保留在活动中的逻辑逻辑演算》,为神经网络奠定了基础 |

| 1950 | 图灵(Alan Turing) | 提出图灵测试(Turing test),用以测试机器是否能够表现出与人等价的智能,现今仍然是人工智能领域相当重要的测试之一。 |

| 1951 | 曼彻斯特大学 | 第一个人工智能程序,运行于Ferranti Mark I引擎 |

| 1956 | 麦卡锡(John McCarthy) | 首次提出“人工智能”一词 |

| 1958 | 发明Lisp编程语言 | |

| 1966 | 维森鲍姆(Joseph Weizenbaum) | 创建了应用Rogerian心理疗法的聊天机器人ELIZA |

| 1960s

1970s |

莫塞斯(Joel Moses) | 实施了计算机代数系统的Macsyma项目 |

| 1969 | 闵斯基(Marvin Minsky)

派普特(Seymour Papert) |

发表了《Perceptrons》一书,展示简单的神经网络边界 |

| 1972 | 科梅侯耶(Alain Colmerauer) | 开发计算机语言Prolog |

| 1970s | 索尔特夫(Ted Shortliffe) | 开发专家诊断系统MYCIN,是最早的人工智能专家系统之一 |

| 1980 | 莫拉维克(Hans Moravec) | 开发出第一台计算机控制的车辆 |

| 1980s | 维波斯(Paul John Werbos)

霍普菲尔德(John Joseph Hopfield) 鲁梅尔哈特(David Rumelhart) 辛顿(Geoffrey Everest Hinton) |

研究神经网络模型,并运用于反向传播算法 |

| 1997 | 深蓝(Deep Blue)超级电脑 | 利用人工智能运算打败国际国际象棋冠军 |

| 2004 | 美国国防高等研究项目署(DARPA) | 车辆运用GPS与先进计算机、传感器跨越数百英里的沙漠 |

| 2016 | AlphaGo | 利用人工智能计算,打败世界顶尖围棋高手李世乭 |

| 2021 | AlphaFold | 利用Graph Neural Network(GNN)来解决蛋白质折叠的问题 |

分类

[编辑]人工智能系统基本上可以分为三种:

- 分析功能:分析功能的人工智能具有认知智能的特征,它主要是利用过去人类积累的知识和经验作为基础再为未来的决策提供信息。

- 人类情感功能:具有情感智力、理解,以及在决策中会加入了人类情感的因素在决策中。

- 人性化的人工智能:具有认知,情感和社交智能的特征,能够与人在日常交往中表现出独有的自我意识和个性。

但是,以到目前为止的发展来说,人工智能与人类智能还是有很大的差距。尽管AI具有强烈的科幻内涵,但AI构成了计算机科学的一个非常重要的分支,处理机器中的行为,学习和智能适应。人工智能研究涉及使机器自动化,需要智能行为。例子包括控制,计划和安排,回答客户诊断和问题的能力,以及手写识别,语音和脸部。这些事情已成为独立的学科,专注于为现实生活中的问题提供解决方案。 AI系统经常用于经济学,医学,工程学和军事领域,如在几个家庭计算机和视频游戏软件应用程序中创建的那样。这种“人工智能”不仅要了解智能系统是什么,还要构建智能系统。

从广义上讲,AI分为两个概念,即常规AI和计算智能(CI,Computational Intelligence)。传统的AI主要涉及现在归类为机器学习(Machine Learning)的方法,其特征在于形式主义和统计分析。也称为符号AI,逻辑AI,纯AI和GOF(Good Old Fashioned) AI。方法包括:

- 专家系统:运用考虑的能力得出结论。专家系统可以处理已知的大量信息,并根据这些信息提供结论。

- 基于案例的考虑因素

- 贝叶斯网络(Bayesian network)

- 基于行为的AI:用于手动创建AI系统的模块化方法计算智能涉及迭代开发或学习(例如,在连接系统中调整参数)。

这种学习基于经验数据并且是相关的具有非符号AI,不规则AI和软计算。主要方法包括:

- 神经网络(Neural Networks):具有很强模式识别能力的系统

- 模糊系统(Fuzzy control system):在不确定性下考虑的技术,已广泛应用于现代工业和消费者产品控制系统

- 进化计算(Evolutionary computing):这些方法主要分为进化算法(Evolutionary Algorithm)(如遗传算法)和群体智能算法(Swarm intelligence)(如天线);为使用混合智能系统,进行实验以结合这两组可以通过神经网络或来自统计学习的生产规则来生成参考规则,如在ACT-R中那样。通过技术加强情报智能是一种加强情报的方法,试图在进化过程中实现人工智能。

强人工智能与弱人工智能

[编辑]“人工智能”这个名词最初是在1956年DARTMOUTH学会上,由约翰•麦卡锡提出的,代表“人工智能”这门新兴学科的正式诞生。在此我们要讨论,从“智能”的本质上来说,人工智能是否真正拥有“智能”呢?也就是说,机器是否能够做到“像人一样理性地思考”或“像人一样理性地做决策”?许多哲学家在探讨此议题,而美国哲学家约翰.瑟尔(John Searle)则提出依照人工智能达成目标的可能性,将人工智能分为两种:“强人工智能”(Strong A.I. 或 Bottom-up A.I.)以及“弱人工智能”(Weak A.I.或Top-down A.I.)。

强人工智能(Strong A.I.或Bottom-up A.I.)

[编辑]强人工智能观点认为“有可能”制造出“真正”能推理和解决问题的智能机器,并且这样的机器将被认为是具有知觉、有自我意识的,甚至可能超越人类。这种观点被称为“Bottom-up A.I.”,因为强人工智能是自底向上主动学习知识,感知和分析情况。强人工智能可分为两种类型:

人类的人工智能:这种类型的机器思考和推理方式类似于人类的思维模式。 非人类的人工智能:这种类型的机器产生了与人类完全不同的知觉和意识,并且使用与人类完全不同的推理方式。

弱人工智能(Weak A.I. or Top-down A.I.)

[编辑]弱人工智能观点认为“不可能”制造出能“真正”地推理和解决问题的智能机器,这些机器只不过“看起来”像是智能的,但是并不真正拥有智能,也不会有自主意识,这些机器只是遵循着我们人类所制定的条件判断与运算来运行程序(也就是Top-down)。

以目前的人工智能的研究进度来看,相关领域的专家已造出许多“看起来”具有智能的机器,特别是在类神经网络的发明及研究在人工智能领域具有相当大的指针性。这些人工智能已经有相当多的实际应用,但对于要如何将这些集成成强人工智能,现在还没有明确定论。

对强人工智能的哲学争论

[编辑]关于强人工智能的争论,其争论要点为:如果一台机器的唯一工作原理就是转换编码数据,那么这台机器是不是有思维的?希尔勒认为这是不可能的。他举了个中文房间的例子来说明,如果机器仅仅是转换数据,而数据本身是对某些事情的一种编码表现,那么在不理解这一编码和这实际事情之间的对应关系的前提下,机器不可能对其处理的数据有任何理解。基于这一论点,希尔勒认为即使有机器通过了图灵测试,也不一定说明机器就真的像人一样有自我思维和自由意识。

也有哲学家持不同的观点。丹尼尔·丹尼特在其著作《意识的解释》(Consciousness Explained)里认为,人也不过是一台有灵魂的机器而已,人可以有智能而普通机器就不能呢?他认为像上述的数据转换机器是有可能有思维和意识的。

有的哲学家认为如果弱人工智能是可实现的,那么强人工智能也是可实现的。比如西蒙·布莱克本(Simon Blackburn)在其哲学入门教材Think里说道,一个人的看起来是“智能”的行动并不能真正说明这个人就真的是智能的。我永远不可能知道另一个人是否真的像我一样是智能的,还是说他仅仅是“看起来”是智能的。基于这个论点,既然弱人工智能认为可以令机器“看起来”像是智能的,那就不能完全否定这机器是有智能的。

需要指出的是,弱人工智能并非和强人工智能完全对立,也就是说,即使强人工智能是可能的,弱人工智能仍然是有意义的。至少,今日的计算机能做的事,像算术运算等,在一百多年前是被认为很需要智能的。并且,即使强人工智能被证明为可能的,也不代表强人工智能必定能被研制出来。

类神经网络(Artificial Neural Network)与深度学习(Deep learning)

[编辑]类神经网络,又称人工神经网络,是一种常用且被广泛研究的一种机器学习算法。它是一种模仿生物神经网络的数学计算模型。在人工神经网络中,许多称作神经元的人工节点互相连接,起形成一个类似生物神经网络的网状结构。近年来类神经网络因为在很多任务作上都表现出远超其他算法的正确率,所以占了人工智能领域的主要地位。

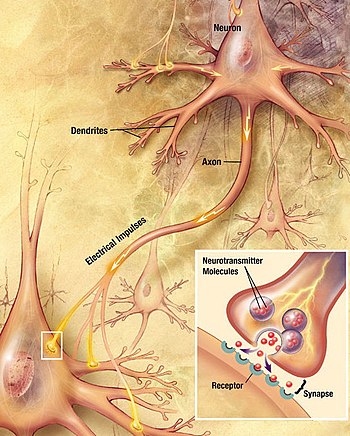

在生物体中,消息处理与传递是由神经元借由传递化学信号与电信号来完成的。神经元主要由树突、细胞本体、与轴突组成,如右图。一般情况下,信号在一个神经元的传递过程是由树突接受刺激起始,将信号传到细胞本体分析后,最后由轴突传出。在复杂的神经传导路径中,可能涉及许多层的神经元,这时前一个神经元的轴突末端会在称为突触的位置释放化学分子,将信号传到神经元的树突,并开始在下一个神经元的信号传导。

我们通常在图上以一个“节点”来代表人工神经元。如下图,人工神经元会接受许多输入,这些输入可能是来自前一层神经元,借由突触传导过来的。因为每个输入所占的的影响比率有所不同,必须要对它们进行加权,我们指定给每个突触一个权重,而最终期望得到一个加权总合。在神经元本体中,会将个总和加上一个起偏值后,得到,这个值称为“引导值”。而继续经由一个活化函数的作用后,即产生输出值。

下表整理了生物神经元与类神经元的功能对应关系:

| 生物神经元 | 类神经元 |

|---|---|

| 树突 | 输入 |

| 细胞体 | 引导与活化 |

| 轴突 | 输出 |

| 突触间隙 | 权重 |

感知器

[编辑]类神经网络发展出的第一个应用实例为1957年由Frank Rosenblatt所发明的“感知器”,这个类神经网络仅含有一个“输入层”与一个输出的神经元,也就是多输入单输出的神经元。虽然感知器有很强大的效用,不过不久后就被证实它只能用来学习出“可线性分离”的模式,因为活化函数值只与引导值有关,而又是一个输入值的线性函数。一如Marvin Minsky与Seymour Papert所指出,此模型无法学习出XOR的基本运算。感知器的活化函数通常遵守神经动作电位的全有全无律,以数学式精确定义如下:

感知器有计算快速、易于解释、方便使用等优点,因此常用在只需要得出离散结果的模型,如满意度调查、商品选择与候选人投票结果等。但是因为它只能用来处理可线性分离的数据,所以适用范围其实非常局限。虽然如此,感知器在人工智能的发展历史中仍然占有很重要的角色。

多层神经元网络

[编辑]以上所介绍的感知器又称为“单层前馈式神经网络”。“前馈式”是指信号沿着神经单向传递,只会从输入层传向输出层;而“单层”则是指输入层后方只有一层输出层。很快的我们发现,可以从感知器的模型往后继续做推广。例如可可以由同一组输入根据不同的加权值产生许多输出,亦即输出层有许多神经元,但这还是在单层网络的线性范围内。同时如果将这许多的神经元输出值,又当作下一层神经元的输入值,则我可以构造数层神经网络,如下图所示。

更精确来说,我们可以定义为“第层的第个神经元”与“第层的第个神经元”之间的权重。若我们将所有层的输入与输出写成向量形式,那么层与层间的权重就可以用一个矩阵来表达。如下述的表示法:

第層的輸入寫為 第層至第層的起偏值寫為 第層至第層的權重寫為 那麼就有以下關係式:

我们将第一层称为输入层,最后一层称为输出层,而中间数层称为隐藏层。由于经过一层的神经元进入下一个神经元的过程中,会经过“活化函数”的作用,如果这个活化函数是非线性函数,则我们就可以摆脱感知器的限制,实现非线性的分类。事实上,“一般定理(Universal approximation theorem)”指出了,任何一个函数都可以利用至少一层(宽度不受限)的类神经网络来无限逼近。

研究课题

[编辑]目前人工智能技术的研究课题主要是利用计算机和机器,通过复杂电脑运算程序来模仿人类的智能技术。而模拟或创建智能技术可以分为不同领域,以下描述的领域是比较多人关注:

- 演绎、推理和解决问题

- 知识表示法:知识表示法的目标是让机器存储已知和相关的知识,并且按照某种规则去推理和演绎从而得到新的知识。已知和相关的知识包括事先存储的先验知识和通过智能推理得到的知识。事先存储的先验知识是指:人类通过某种方式存储在机器的知识。通过智能推理得到的知识是指:结合先验知识和某种特定的推理规则“逻辑推理”而得到的知识。目前知识表达法有许多困难尚无法解决,比如:由于资源限制,创建一个完备的知识库几乎不可能;先验知识库的准确性需要事先进行检验,而且先验知识有时候不一定是只有对或者错的两种情况。

- 规划:人工智能的核心智能必须能够制定目标和实现这些目标。核心智能以数学模型创建一个可预测的世界模型,并以这模型来预测将来可能发生的事情,同时提供最好的方案予决策者选择。

- 学习:机器学习是让机器从用户和输入数据等地方获取知识,从而让机器自动地去判断和决定如何运算,最后再输出相应的结果。以下分别详细介绍机器学习的四种分类以及学习步骤流程。

机器学习的流程大致上可归类出以下依序七个步骤:

- 收集数据

为了便于理解,假设我们要训练机器判定一杯酒是啤酒还是葡萄酒。在机器学习之前,我们必须选定哪些指针作为判定依据。这一步骤非常重要,因为它直接影响训练机器的效率和准确性。以本例为例,我们可以选择颜色(变量 x)和酒精浓度(变量 y)等指针,然后设置相关测量设备来收集这些数据。

- 准备数据

在获取相关数据后,我们就可以开始整理欲输入机器的数据了。在这里要将数据分成两组,第一组数据是用来训练机器(第4步骤),使机器具有判断分析能力。第二组数据是用来测试训练出来的成果(第5步骤),用来评估模型的合适性。同时,在这里我们应该也要简单判断一下输入的数据是否恰当,比如说,如果用来训练的数据啤酒占了大多数,而葡萄酒只有少数几杯时,那么可能会造成训练出来的结果会使判断过度偏向于啤酒。 - 选择模型

依照输入与输出数据模式的不同,我们也应该要选用不同的模型来作学习。机器学习有许多常用的相关算法,在不同情况时可以妥善的选择运用,常见的三种学习模式在下一个部分会详述。如在本例中,我们就可以使用有关分群的算法来解决问题。更精确来说,我们设计的模型可能是,当 mx + y + b > 0时判断为啤酒,而当mx + y + b < 0时判断为葡萄酒,其中m和b为未知的参数,将在下一个步骤决定。(x为颜色,y为酒精浓度)当然此模型不一定是好的,在这里只是举例说明而已。 - 训练机器

这部分是机器学习的重点关键步骤。在上一步骤选用的模型中,有许多参数(如m和b)是还未决定的。在此步骤中,我们会将第2步骤准备的数据输入机器,并经由上述模型的判断结果与正确结果进行比对,如果比对结果不佳,就应该调整模型中的参数。在经过一次又一次的重新判断、比对并修改参数的过程中,会使判断的正确率逐渐提高。如果比对的正确率一直不如预期却也不再上升,那么可能是上一个步骤选用的模型不够好。 - 评估分析

当机器训练至正确率不再提升、或者已经达到足够的正确性时,就可以将第2部分准备好的测试数据拿来检验机器训练的成果。毕竟若训练结果与学习数据非常拟合(甚至可能会有过拟合的状态出现),也不代表对于其他的数据也适用。这时候就需要用额外的数据来做检验,若不适用,则重新回到选择模型之处。 - 调整参数

若此学习成果评估之后视为可被采用,那么我们可以继续给予更多的数据始之学习,可以对参数做一些更精确的微调。 - 预测推论

经过以上重重的步骤,最后我们的机器就有一定的判断能力,可以依照数据来预测或者推论结果了。

学习模式

[编辑]机器学习依照学习以及输出模式的不同,分为三个类别:监督式学习、非监督式学习、强化式学习。

- 监督式学习(supervised learning)

在这种学习模式中,我们会先为准备的学习数据(数据)进行“标签化”的程序。这些标签就像标准答案,训练过程中判断的结果可以和此标准答案进行比对,以修正参数获取正好的正确性,因此一般来说监督性学习的准确率是较高的。不过监督式学习在收集数据以及准备数据的程序上需要耗费较大的人力,所以面对未知领域时会遇到瓶颈。

举例来说,上述“分辨啤酒与葡萄酒”即是一种监督式学习,因为提供给机器学习的数据中有标示哪些是啤酒、哪些是葡萄酒(标签)。另外常用的例子如分辨垃圾邮件的工具等,可以使用监督式学习的方法来实现。 - 非监督式学习(unsupervised learning)

在非监督式学习中,提供机器学习的数据不必以人工加上标签。机器会依照算法来查找数据的共通点,依照“物以类聚”的特性加以分类,但机器本身并不知道分类结果是否正确。由于不须加上标签的特性,使它成为数据挖掘初期的好工具,且能大幅减少人力需求。不过缺点是,非监督式学习的功耗较大,且正确率较监督式学习低,且可能造成非重点特征被过度放大。聚类分析(Cluster analysis)是最常见的一种非监督式学习,且在其中K-means是最常用的算法。

而监督式学习与非监督式学习的差异比较:

监督式学习所需的数据是有固定答案的,就像我们看到照片,一眼就可以说出照片中的物品名称。在此学习模式下,识别后的数据会分成连续数据、离散数据以及分类数据,再以个别定义赋予回归、分类、预测功能,而线性/逻辑回归、神经网络,便是这些功能常用的算法。

非监督式学习所需数据没有固定答案,依据相似度进行分类,例如:一堆不知名的黑色物品跟白色物品,会下意识依照同颜色做分类。也因为数据答案尚未得知,需要用不同预测功能来分类,比如:依照相似度做区分的聚类功能、以日常行为来预测的推荐系统、或是删减数据相关度低 的降维。

- 增强学习(reinforcement learning)

在强化式学习中,我们不需要给机器任何的数据(但需要提供机器交互的模拟环境),机器会透过与环境的交互中去学习,这也是接近人类最自然的学习方式。

强化学习的一个经典理论是“马可夫决策过程”。在过程中,机器会借由现在的状态转移成下一个状态。若转移的过程使得与目标距离更接近,则会得到一个正向反馈,若与目标距离更远,则会得到一个负向反馈。虽然我们不会明确地将每一步的好坏标签化让机器读取,不过它会根据反馈的好坏,逐渐修改内部的参数,最后得到有效力的结果。

以下棋来举例,我们可以设置一些参数,由这些参数可以计算棋盘状态的反馈函数。如果此状态与赢棋的状态越接近,就反馈越高的分数,机器则会选择使接下来分数最高的步数来下。那么我们只要利用两组不同的参数的机器互相对弈,就可以根据输赢的结果慢慢调整参数,使胜率提高。如此一来,我们只要告诉电脑基本的规则,则可以让其依照自我对弈的过程中,找出胜率最高的下法。

虽说增强学习不需要任何数据,但增强学习目前是这三种学习方式里面效率最差的。以最常见的训练机器玩 Atari 小游戏为例子,如果我们用最单纯的增强学习算法来训练的话,机器通常需要玩一个游戏数以万计次才能达到人类中位数的表现。相较之下,人类通常只需玩个 10 ~ 20 次就可以上手。

以上介绍的三种机器学习模式,是根据他们的“学习风格”来做分类的。我们也可以根据实现的方式不同,而将这些实践学习的算法分类。以下列出并简单介绍几种常见的机器学习算法。

- 线性回归 (Linear regression)

线性回归是统计学和机器学习中最知名的算法之一。

机器学习中,我们对于每一组输入变量(X),都决定一组输出变量(Y),机器学习的目标就是量化输入变量与输出变量之间的关系。在线性回归中,会假设输入变量(X)和输出变量(Y)之间满足Y = a + bX这个线性关系,并找出系数a和b的值,(其中a是截距,b是线的斜率)。

更一般来说,设输入变量为随机样本,线性回归的目标就是要找到一组参数,使得在与的关系中,(或称为误差项)的平方和最小,即最小。此方法称之为“最小平方法”。 - 逻辑回归 (Logistic regression)

线性回归预测是连续值(例如以cm为单位的降雨量),逻辑回归预测是应用转换函数后的离散值(例如学生是否及格)。Logistic回归最适合二进制分类(y = 0或1的数据集。例如:在预测事件是否发生时,发生的事件被归类为1,未发生为0)。它以其中使用的变换函数“逻辑斯函数”命名,数学式写为,它是S形曲线。 - 决策树(Decision tree)

决策树是由许多决策节点构成,每个节点均有检察某特定属性的变量,而“叶节点”,即最终端的节点,则是表示目标变量之值。决策树是一种分类器,从根节点开始,逐步向叶节点移动,即可达成分类的效果。生物分类法的分类树即为一例。 - 集群算法(K-means )

集群算法是一种非监督式学习的机器算法,而最常见的集群演散法即为K-means。此算法的目的是要将所有样本分类至k个不同的子集群之中。我们以下列的顺序来达成此算法的目的:首先,随机选择k个点,接着对于每个质心,都找到与其距离最近的点,并将这个点与质心结合为一个组群起来。此时我们从新计算每个子集合的中心点,并将此中心点重新定义为此集合的质心。接着重复以上步骤(找最近的点、重新定义质心),直到质心不再移动为止。

实际应用

[编辑]下面介绍几个人工智能的实际用途。

- 自然语言处理

- 自然语言处理(Natural Language Processing,又称NLP)是人工智能和语言学领域的分支学科,在于探讨如何处理及运用自然语言。自然语言处理包括多方面和步骤,基本有认知、理解、生成等部分。自然语言认知和理解是让电脑把输入的语言变成有意思的符号和关系,然后根据目的在处理。自然语言生成系统则是把计算机数据转化成自然语言。

- 用途:

- 在许多情况下,学者们需要通过许多不同的数据库来确定新的研究方向,以识别研究差距并确定迄今为止尚未研究的领域。检查所有的数据库很麻烦,而且经常会遗漏重要的部分。通长会使用网络抓取和自然语言处理来缩短识别研究差距所需的时间。

- 在Google学术搜索上索引的出版物的标题, 自然语言处理标记化(Tokenization)从最高频率到最低频率对搭配进行排序。因此,自然语言处理标记化(Tokenization)确定了标题中未提及的关键字集,并将最初的想法确定为研究空白。

- 自然语言处理的难点:

- 单词的边界界定:在口语中,词与词之间是连贯的,而界定字词边界通常使用的办法是取用能让给定的上下文最为通顺且在文法上无误的一种最佳组合。在书写上,汉语也没有词与词之间的边界。

- 词意的消岐:许多字词不单只有一个意思,因而五们必须选出使句意最为通顺的解释。

- 句法的模糊性:自然语言的文法通常是模棱两可的,针对一个句子通常可能会剖析出多棵剖析树,而我们必须要仰赖与语义以及前后文的信息才能在其中选择一棵最为适合的剖析树。

- 有瑕疵的或不规范的输入:例如语音处理时遇到外国口音或地方口音,或者在文字的处理中处理拼写,语法或者光学字符识别(OCR)的错误。

- 语言行为与项目:句子常常并不只是字面上的意思。例如:“你能把盐递过来吗?”,一个好的回答应当是动手把盐递过去。在大多数上下文环境中,“能”将是糟糕的回答,虽说回答“不”或者“太远了我拿不到”也是可以接受的。再者,如果一门课程去年没开设,对于提问“这门课程去年有多少学生没通过?”回答“去年没开这门课”要比回答“没人没通过”好。

- 感知

- 机器感知是指能够使用传感器所收集的数据,然后推断外在环境的状况。

- 防治传染病

- 人工智能系统在预测流行疫情爆发方面被广而利用,医学流行病学人工智能系统可以提前三个月凖确预测登革热疫情爆发,凖确率达到 88% 左右。在医学领域,以疟疾为例,过去一旦医院收到疑似病例,需将影像档送至疾管署,以人眼判读是否感染,现在得益于人工智能的辅助,经过半年多的训练,电脑判读恶性疟原虫准确度超过9成,未来有望创建疟疾血片数据库。

- 由于人工智能的发展,未来也有望能够使用完善数据导入大数据分析,使人类对于流感的预测能够更为准确。[1]

- 应对枪械暴力:有一种自动化系统利用传感器监听枪声(ShotSpotter),然后精确计算枪声所在的位置,并在 45 秒内向相关机构发出警报。机器学习技术被用来确定声音是否是自动武器枪击声,并计算出它们的数量,从而帮助警察确定他们要对付的是独行枪手还是有多名枪手。

- 预防饥荒:研究人员与植物病专家合作开发了一套人工智能系统用于消灭木薯疾病。Mcrops项目允许农民使用智能手机拍摄植物,并使用经过训练的计算机视觉来查看造成木薯作物损害的四种主要疾病的迹象。

- 控制电力应用:研究人员正在开发机器学习运算法,以实时监控能源生产和需求。这样做当需求处于低位时,能源可以存储起来,然后在高峰的时候再释放出来。随着电动汽车和电池越来越普及,这项技术可以利用这些设备存储能源,并消除可再生电力供应不稳定的问题。

- 商业应用:将人工智能技术与商业智能结合能够为商业活动带来巨大经济利益,包括作业的高精准度、改善决策、降低风险、节省劳动成本、提高安全性、提高操作效率进而提升营业额。

- 举两个例子,第一个例子为智能法遵分析,AI能够建构法规数据库及自动分类法规,并监管有异动的规范,达到自动、即时及精准监控的效果,也能够借由比对找出相关法规及提供建议,大幅降低法遵成本。

- 第二个例子为美国新创保险科技公司Lemonade,此公司将过去由保险业务员负责的工作由AI取代,把贩售保单与客户理赔的过程都交给保险业务智能机器人来运行,大幅缩短处理时长及解决繁琐程序的问题,此外,也透过机器学习分析并判断适合顾客的保险金额及类型,节省人力成本,Lemonade结合AI机器学习技术与商业活动,成功成为保险科技公司的典范,甚至胜过其他传统保险公司。

- 医学诊断上之应用:人工智能于医疗上的最大应用,也是相较于人类最大的优势,即是数据分析。而依照数据分析的数据特性又大致可分为以下四个不同的种类:

- 编码数据:有许多医疗相关的数据都经过标准编码,且经过编码过的数据,对于电脑而言知识密度最高,且最容易使用。如台湾在健保制度下的电子病历即是一例。

- 影像数据:利用人工智能来进行医疗检查的相关影像数据,将可以有效减低医师的负担,并且AI在影像判读的速度与正确率都渐渐追上人类甚至优于人类。事实上,在2015至2016年间,荷兰Radboud大学医学中心的团队已由实际测试证实,以深度学习算法训练的人工智能来诊断乳腺癌组织切片中淋巴结的转移,其正确率与专业的病理学家相当。台湾因健保给付而减低医疗检查的成本,使医疗检验成为家常便饭,所以若使用AI来处理大量影像数据,也可减少人为判断疏失的风险。

- 自由文字:指人类使用的语言,包含语义、文法,以及前后文的呼应。这些自然语言处理的技术,已经有许多成功的例子,如Siri、Google Home等,而在医学领域的代表则为能够辅助癌症诊断的IBM Watson,它已经进化到能够帮人类读文章。而值得注意的是,中国科大讯飞开发出的AI机器人“小易”高分通过2017年临床执业医师的笔试。此机器人是借由“多语义深度学习”的方法自主学习并理解题目,利用推理判断能力来解题,并非使用题海战术。此能力能够使机器人学习各种临床医学数据,创建完整的医学知识库。

- 生理信号数据:近来的发展趋势是希望能利用各种穿戴式设备,来持续的长时间收集病患的心跳、血压、呼吸等生理信息,这些大量的数据会由AI进行有效率的分析。此为人工智能与物联网的结合应用。

- AI 在医疗照护上,最终的目标是要达到精准预测以及精准预防。以目前的医疗实况来说,往往是“只看疾病不看个人”,但因为年龄、性别以及个体上更基本的差异等也会影响到特定治疗方法对于个人的疗效不同。不过若要将这些种种因素全部考虑进来,对于人脑来说几乎是无法办到的,于是需要AI的辅助下才有可能完成。我们希望AI针对某些问题能够提供医师客观理性的协助,或者评估某疾病的发生率甚至预后分析等,这将会对医疗方面有莫大的帮助。越来越多疾病的诊断在大数据的统计下可以比医生人为的判断更为精确,也可以在各种主诉中查找交集,找出最可能患病的原因。2014年《神经学》期刊在一篇探讨“帕金森氏症诊断准确率”的研究论文提出,从过世的帕金森氏症病患大脑解剖,回头查看生前医师给他们下的诊断,在病人刚发病时,只有26%医生下了正确的诊断;再经过3、5年,看病人的神经反应、行为、对药物的反应,诊断正确率可以达53%;拉长到8年、10年,准确度可以超过85%。其中人工智能在医学上最出名的应用是一台叫做“Watson”的机器,利用其精密的数据分析及计算器巧,可以帮助人类对于信息的获取更易理解和方便。另外IBM的Watson AI(人工智能系统)可以分析图像,并评估病人的诊断书,从而凖确地识别出肿瘤病例,凖确率高达96%。但是此医学应用之于人类的接受度还是个未知数,毕竟其作为医生还是少了人性化的部分,但其作为医学辅助器具想必会是个很大的突破。

- 语音应答

- 人工智能其中一个研究重点就是使机器能直接用人类语言与人类沟通,这是有一定难度的。首先机器要先能具备识别语音的功能,再来还要能理解一段话的意思,最后产生符合当下情况的应答,还要能将这个应答转为人类语言。由于人类对语言的延迟非常敏感,所以上述程序需要被处理得相当迅速;另外,人类自然对话会讲得十分快速、不清楚,以及同一句话会因为上下文的不同而有不同意思等等,种种因素都让机器与人类对话非常困难。

在2018年,Google在其发表会上展示了Duplex,其可以为用户打电话给餐厅、发廊的真人店员进行预约、订位,而且两家店的店员都没有察觉到与他们对话的是一个机器人。在发廊的预约电话中,当店员说请稍后一下时,Duplex回应了“嗯哼”,并等候店员几秒,这证明了Duplex可以了解对方语义,并使用似真人的应答模式;而且在Duplex欲预约时刻客满的状况下,Duplex给出了一个时段,让店员选出一个有空的时间。而在餐厅的预约电话中,店员说毋需预约,Duplex不仅了解语义,甚至还主动询问了餐厅等候的时间。

Duplex的功能还只限于替用户预约时间,但是它的出现告诉了我们,实现真正机器与人类的自然对话不是不可能的;但这也产生了伦理道德争议,人类其实不愿意自己在不知情的状况下与机器对话,以及在对话中双方的地位与责任究竟要如何区分,还需要仰赖大众广泛的讨论。

- 人工智能其中一个研究重点就是使机器能直接用人类语言与人类沟通,这是有一定难度的。首先机器要先能具备识别语音的功能,再来还要能理解一段话的意思,最后产生符合当下情况的应答,还要能将这个应答转为人类语言。由于人类对语言的延迟非常敏感,所以上述程序需要被处理得相当迅速;另外,人类自然对话会讲得十分快速、不清楚,以及同一句话会因为上下文的不同而有不同意思等等,种种因素都让机器与人类对话非常困难。

- 影像处理

- 过去修图软件已可轻松移除静态照片内不想要出现的物体,然而这项工作换到影片处理上,立刻变得繁杂而且得不到好的效果。原因在于影片是由数百甚至数千、数万张的帧组成,即使每个帧单独处理过,播放时仍可看见明显的编辑痕迹。然而利用深度学习的技术,电脑可以猜测被选取物体背后之像素,并自动进行移除与填补修复。这项技术在Adobe Max 2017活动上展示的Project Cloak中可以看到十分完美的成果。这项功能提供了未来电影工作室一个更有效率的影片合成的选择,也让修改影片更轻松而且看不出痕迹,然而是否会被有心人士拿来做不法用途,则是另一个隐忧。[2]

- 脸部识别(Face perception)

人工智能与认知心理学之间的关系

[编辑]人工智能(AI)研究机器的认知。而 AI 的目标,其中之一就是运用计算机实现人类的智能。

如今,人工智能在运算方面已经远远强于人类,然而,“智能”牵涉到的不仅仅止于运算,而是包括了意识(Consciousness)、自我(Self)、思维(Mind)(包括无意识的思维(Unconscious mind))等问题。因此,对人类智能的理解亦是与人工智能习习相关的研究课题。此外,相关科学家也利用认知心理学去理解人工智能的思考逻辑,以下是近期的例子:

DeepMind 研究团队利用理解儿童的方式来理解人工智能──透过对儿童的认知心理学测试试图理解 AI。研究团队发现 AI 拥有与人类孩童相同的偏好,它们更喜欢透过形状而非颜色对物体进行分类。这是首次将认知心理学引入深度神经网络的研究。可见人工智能与人类的认知有着密不可分个关系,两者的研究也能相辅相成。

- 如何解读 AI 的思考

- 在机器学习中,工程师先是编写了类似原始大脑的神经网络,再透过给予大量数据来进行训练,机器则从中学习辨别与理解,就像大脑运作的方式一样,也因为如此,AI“思考”的方式人无法理解。这个困境工程师称之为“可解释性”问题,而神经网络则称为“黑盒子”──你可以刺激并观察,但无法理解内在。身为现今最知名 AI“AlphaGo”的开发者,Alphabet 的子公司 DeepMind 研究团队也希望解决这个问题,因此决定用一个全新方式来了解 AI:就像对待人类的孩子。这并不是一个比喻,DeepMind 的研究科学家 David Barrett 表示,团队正在使用和心理学家用在孩子身上的认知心理学技术及测试,来试图了解 AI 的想法。Barrett 认为,认知科学对人脑的研究已有数十年,如果应用到机器的过程顺利,将能理解 AI 的思考模式,并为它的决定负责。在研究中,DeepMind 至少已理解了 AI 的一种学习模式:一次性学习思考。这个设计原先是用来让 AI 看过一次项目后,就学习单字的意思,DeepMind 意外发现,AI 解决这项问题的方式和人类相同,是透过形状来辨别物体。研究人员发现,即使没有着指导,也存在着许多方法来识别随机对象,像是颜色、质感及行为模式,AI 却是选择像人类一样用形状来识别物体,这样的行为模式是以前未曾察觉的。

- 机器人心理学

- 类似这样对 AI 思考的理解只是开始,就像人类心理学一样,机器人心理学未来也可能发展出一种“治疗”行为──也就是去改变 AI 的心态。工程师在创造 AI 时,经常会选择创造多种版本,以便于从中找出最好的来使用,Barrett 认为,透过认知心理学的应用,工程师可能会更容易创造出“想法”符合人类需求的 AI。又或者,我们也可能从中发现,AI 的思考模式与人类有所不同,人们或许能从中学习到一些新的东西,像是该如何解决一些问题。在用人工智能取代人类决策者时,我们总是希望机器做得更好,犯更少错误并承担责任。当 AI 的产出能被衡量,人们或许就能够追踪它们做决定背后的过程。在现今法庭中,我们总是由人来解决商业问题上的争执,如果改由机器取代人力,我们或许就能够观察到“决策者”在过程中的心态转变,与所有可能出现的偏见。

争议

[编辑]融合了deep learning和fake两个单字,是一种人像产生的AI程序,其原理是利用给定的人物特征,将其合成到目标影片或图片上。这项技术相当方便,有相当广的运用。

NVIDIA在2018年公布了多项研究成果,如:

- Image Inpainting可将图片缺损的地方自动补起来,就算是人脸双眼都被涂掉,仍可以将图片修复为自然的人脸,或是它也能将图片中我们不想要出现的东西修掉。

- vid2vid这项技术可将草稿影片与图片输出自然的成品,如输入的影片只是线条勾勒的人脸在说话,vid2vid可以自动将其填入颜色与细节,生成一个自然的人在说话,而我们也可以进行颜色、氛围的调整。[4]

- Style-Based Generator不同图片视为有不同的风格,在不需要人类参与训练过程的情况下,可以将两张不同人像,个别选择不同的特质以供合成,甚至可以微调各项参数特质的强度,比如说头发的卷度、人像角度、年纪、性别等等。

- 我们知道影片其实就是多张图片连贯放在一起,一秒钟有几张图片我们称之为帧数(fps),帧数高影片就流畅,反之则不流畅。将影片速度放慢其实就是把换下一张图片的时间拉长,因此帧数会下降,所以影片放慢是有极限的。Super SloMo则是将一段影片中再插入新的影像,参考的是前后几张图片,在中间生成一张新的图片,由此我们可以将一段影片的帧数提高,再将其放慢,就可以生成高质量的慢动作影片。[5]

- 很多人在使用电脑的时候会将前镜头贴起来,一来是因为不常用到这项功能,二来是为了前镜头可能会受到黑客攻击而进行远程监控,而研究人员发现,电脑或是手机随附的麦克风竟然也可以用来监控用户的行为,利用屏幕的电流噪音,配合上该厂牌屏幕的显示原理,便可以透过录音分析出屏幕上显示的内容[6]。其研究目标是将屏幕软键盘按下的字母还原至以下十八个区间内:'b’, ‘c’, ‘m’, ‘n’, ‘p’, ‘v’, ‘x’, ‘z’, ‘aq’, ‘sw’, ‘de’, ‘fr’, ‘gt’, ‘hy’, ‘ju’, ‘ki’, ‘lo’, 和空白键。研究结果显示,使用高端麦克风录音重现屏幕上的文字准确率达100%,而手机的麦克风录音的准确率也可以达97%。

这些技术若遭到滥用,很明显的影响不只是个人,有心人士可以从中牟利,可以是金钱上的获利,乃至政治上、国家安全上的问题,因此AI可以帮助我们是一回事,但要怎么预防AI犯罪又是另一回事了,或许在科技发展的同时,我们也要想好因应策略才是上上之策。

贫富差距、失业

[编辑]自人类发展的历史来看,每当一项改革性的技术大规模应用时,许多职业会面临被取代的危机。目前AI的其中一个目标就是达到真正的自动化,由AI自行判断在流程上可能会遇到的问题并自行修正解决,如自驾车技术的出现。目前各科技与汽车大厂纷纷参与开发自驾车,如此一来许多以驾驶维生的人会面临到失业的问题,例如计程车司机、公车司机等等,或是近年流行的食物、生鲜外送也会被取代掉。除了司机可能会被取代以外,许多能够被拆解成重复、离散的工作,包括律师助理人员、记账人员等等,透过自动化,减少了对行政技能的需求,这些工作就会慢慢消失。也许多种新的就业方向将产生,不过新技术的出现代表产业入门门槛很可能会比原工作更高,无法适应的人类就会面临失业,可能导致阶级分化更严重。

错误及偏见

[编辑]就如人一般,机器不可能是完美无缺点的,正常运作时可能不会产生问题,但若有人刻意破坏“正常情况”,便有可能为其所利用。例如研究者发现,如果在语音识别系统中输入特定噪音,就能够改变翻译结果,甚至让机器说出特定的语句;另外,现今AI几乎都是用机器学习来训练模型,所以开发端给什么数据,这个模型就会偏向数据的特性,因此开发者可能无意识中将人类有的偏见也带入该AI模型中,而人类又偏向相信电脑不会偏袒任何一方,比如说罪犯预测系统,可能会因为提供的数据很多都是某个人种,最终训练出的AI会对此人种有“歧视”的情形。

因此,在进行机器学习时,研究员可以针对一个已经成熟的算法给予其“对抗例”。“对抗例”指的通常是一种人为设计的问题,去挑战一个算法是否是完备,还是可能仍不够完善,仅能回答原本建构这个算法时的那些问题。例如一成熟算法可以判断“照片中的动物为何种动物”,“增加人为噪声且不影响人类判读的照片”即可视为一对抗例,若获得了错误的答案,可能算法就需要修正。过去的一项研究中,机器学习要训练虚拟的人A在另一人B的阻止下移动至对面,而A最后训练出来的方法却是一开始要向前倾去抵挡B阻挡的推力,因此后来研究员给予一“对抗例”即B只会站在那里不动时,反而A会直接向前倾跌倒,这个对抗例即呈现了这个算法不够成熟。

为了避免这样的问题,我们需要更加仔细的查看我们给予机器学习的数据丰富程度是否足够代表该任务,或者学习的方式是否会导致成果非常局限于只能处理我们提供他练习的问题。

伦理

[编辑]由于现今的人工智能几乎都是基于类神经网络的想法,其占了人工智能领域的主要地位,数据输入后,会进行非常大量的运算,因此我们很难知道机器如何处理数据;再者,因为在实验室或实验场的控制条件下,常常情况就是非黑即白的,但是现实生活中并不是如此,通常没有绝对的对错。

若电车问题发生在自驾车行进的过程中,由于我们不清楚机器如何运算,因此我们也没办法预先知道机器会做出什么选择,且机器在训练过程中可能没有这种数据,当问题产生时,究竟责任是在于谁,是工程师?是汽车制造商?是在车上的驾驶员(乘客)?还是被撞到的人事物?光是责任厘清就非常困难了,再加上可能会有人产生自驾车究竟有没有权力代替人类行驶的疑问等等,都还需要相关专家与大众进行讨论与改变。

此外,若是医学机械手臂在操作手术时发生失误,包括突发性断电、机器人碎片掉入患者体内等,或是在诊断病人病情时出现误判,前者严重时可能造成患者死亡,后者则可能将误导治疗方向,对病人而言都是不可挽回的错误,此时相关的赔偿及责任归属也不易判断,在此议题被解决或是成立相关法规前,即便机械手臂的高稳定性可以省下医护的负担,大多时候也能达到精准医疗的效果,大众却仍会对此技术存有疑虑。

过去也曾经发生过新泽西窃盗案件,当时警方利用人工智能的人脸识别系统企图逮捕犯人,却因为嫌犯与一名民众的五官过于相似,而发生人工智能鉴识错误将两人的脸搞混,进而使警察抓错人。虽然将人脸识别应用在抓捕犯人上能够省时省力,一般而言错误率也较低,然而一旦发生误判,对无辜的人民而言却带来相当大的迫害,例如案例中的无辜男子便因此被当成代罪羔羊做了几年牢,严重侵害他的人身自由权。此外,将全民的脸部存储在警政系统也可能有隐私的疑虑,甚至若是通缉犯做了整形手术,人脸识别系统便无用武之地。因此,在真正应用之前仍须经过严谨的测试。

数据获取来源与过程的争议

[编辑]在人工智能进行数据挖掘及学习的过程中,需要提供机器大量的数据。以医疗方面的应用为例,我们希望能够借由这些数据研发出协助医师处理信息及诊断的人工智能。而数据的获取来源与过程,不可避免的引发了一些争议,特别是利用病患的生理数据来进行研究、甚至研发商业产品的情况。以下整理了几个代表性的案例。

第一个案例是Google DeepMind为了测试一个用来测量肾脏健康状态的APP,而收集了伦敦皇家自由医院的160万条患者的诊疗纪录。英国当局认为此行为违反“患者隐私法”,而这个事件后来也被BBC报道出来。

第二个案例与著名的Hela细胞系有关。1951年约翰霍普金斯医院的医师从患有子宫颈癌的女子Henriatta Lacks的子宫颈收集细胞并培养,最后变为世界上第一个永生细胞系。此细胞系后来在实验上被广泛的研究,但是她的家族并无得到任何补偿,且在Henriatta Lacks去世20年后才知道这件事。虽然2013年NIH与其家人已达成研究相关的协议,不过她的家人仍然对此事耿耿于怀。

第三个案例仍与活体组织培养有关。1976年John Moore于加州大学洛杉矶分校接受白血病的相关治疗,医师在治疗过程中因为想要研究某些现象,从他脾脏取出的细胞创建了一个细胞系,最后他的细胞甚至被用做商业用途,然而这件事并不为Moore所知。虽然不可否认的,医师对于Moore的白血病做了相当良好的处理,不过在1990年Moore得知此事后仍然决定起诉。法院认为Moore虽不拥有医师创建的细胞系,但医师有义务将此细胞系的相关研究以及商业用途告知Moore。最后Moore与其医师在庭外达成和解,不过Moore仍有被欺骗的感觉。

接下来是这些案件的伦理讨论。数据获取的相关伦理争议,主要是基于“科学研究成果或商业价值”与“患者权利”之间的冲突。有一派的观点认为,对于患者来说,无论是活体组织或者是生理数据都属于这个人的相关信息。虽然这些数据是医师所创造的,但与患者之间的直接关系性是不能被忽略的,也就是说,患者也应该享有部分与之相关的权利,例如查看这些数据的权利。在法律诉讼案中,某个小孩出生的血液样本被拿来进行研究,其母亲表示:若研究人员来询问她,她会同意的。人们普遍会同意,不过他们希望至少被告知并征求过他们的意愿。因此,若医师要使用这些数据来进行特定用途,有必要进行“告知同意”。

另一个观点则认为,从患者身上获取的数据,经过适当的处理之后并不能识别出特定病人的个人信息,特别是在数以千计的同类型数据当中,单笔数据并没有特别的含意与价值(当然细胞系等较大的应用除外),且无法判定这组数据是来自哪个病人,因此在此情况下并不会涉及“个人隐私”。并且根据目前的法律规定,病患的医疗数据属于卫生系统的财产,病患本身并无所有权。但虽然在患者握有的所有权本身没有太多在法律上的论点,在伦理上却是值得探讨的。

所以总结以上,患者虽不拥有这些医疗检测数据的所有权,但是医师在使用这些数据时却有告知病患的义务。除了以上所述的问题之外,还有另外一个比较积极的问题是:这些提供生理数据的患者是否享有部分学术或商业利益的权利?为了避免病患权利受损,此问题可能值得更进一步的思考与讨论。

假信息误导

[编辑]人工智能的发展,在影像及语音上的成果最丰硕,除了将影像中物体移除或移花接木、将模糊图片清晰化之外,甚至可以在训练过后,从无到有生成鸟类或花朵的图片[7]。而最新的成果包含可以生成高清的风景照,例如Google就利用街景图在世界各地所搜集的数据,合成出令人屏息的专业风景图[8]。然而这类的技术逐渐普及的同时,我们已可在各类的社群媒体上见到编辑过的假照片、影片,使得许多阅听人信以为真。虽然要判断影像是否为合成仍有迹可循,但乍看之下仍不好发觉而容易被误导。如此的操作可能被用于制造假新闻、抹黑特定人物、甚至能左右重要选举,造成的影响可能不止于个人,而很可能改变整个社会甚至政局的发展,绝对不容小觑。

参考资料

[编辑]- ↑ https://health.ettoday.net/news/1210503# ixzz5ZjxBStr2

- ↑ Kunz, M. A. (2017). Cloak: Remove unwanted objects in video. Adobe. https://research.adobe.com/news/cloak-remove-unwanted-objects-in-video/

- ↑ Rossion, Bruno; Hanseeuw, Bernard; Dricot, Laurence.Defining face perception areas in the human brain: A large-scale factorial fMRI face localizer analysis

- ↑ Wang, T. C., Zhu, J. Y., jiaxianhua, & Liu, M. Y. (July 4, 2019). NVIDIA/vid2vid: Pytorch implementation of our method for high-resolution (e.g. 2048x1024) photorealistic video-to-video translation. GitHub. https://github.com/NVIDIA/vid2vid

- ↑ Alarcon, N. (Jun 18, 2018). Transforming standard video into slow motion with AI. NVIDIA Developer. https://developer.nvidia.com/blog/transforming-standard-video-into-slow-motion-with-ai/

- ↑ Genkin, C., Pattani, M., Schuster, R., & Tromer, E. (Aug 21, 2018). Synesthesia: Detecting screen content via remote acoustic side channels. https://www.cs.tau.ac.il/~tromer/synesthesia/

- ↑ Tata, V. (Jan 11, 2018). Understanding and building generative adversarial networks(GANs)- deep learning with PyTorch. Medium. https://becominghuman.ai/understanding-and-building-generative-adversarial-networks-gans-8de7c1dc0e25

- ↑ Zhang, M. (Jul 14, 2017). Google uses AI to create professional photos from street view shots. PetaPixel. https://petapixel.com/2017/07/14/google-uses-ai-create-professional-photos-street-view-shots/