超普通心理学/智力/人工智慧

| 超普通心理學 |

|---|

| 心理學緒論 |

| 心理學研究法 |

| 行為的生理基礎 |

| 感覺與知覺 |

| 感覺系統‧知覺系統 |

| 意識 |

| 睡眠‧夢 |

| 學習 |

| 記憶 |

| 感官記憶‧短期記憶‧工作記憶‧長期記憶 |

| 語言與思考 |

| 認知科學‧語言‧思考 |

| 智力 |

| 智力理論‧人工智慧 |

| 發展心理學 |

| 動機與情緒 |

| 情緒的種類 |

| 壓力與健康 |

| 性格 |

| 常見的人格障礙類型 |

| 心理異常 |

| 心理異常的治療 |

| 社會心理學 |

| 社會認知、基模、歸因、態度‧自我 |

人工智慧 Artificial intelegence 定義:人工智慧是打造電腦與機器的科學領域,這些電腦和機器可以進行推論、學習以及採取行動,而這類行動原本需要人類智慧判斷或涉及超出人為分析能力上限的資料規模。其廣泛的版圖,包含許多不同的專業領域,例如電腦科學、資料分析與統計資料、硬體與軟體工程、數學、語言學、神經科學,甚至是哲學和心理學。雖然人工智慧由人類編程,其所知也是人類多年的研究成果,但其對於資訊的處理、解讀與連結能力也遠高於人類大腦的能力。

計算機科學將人工智慧研究定義為對「智慧代理人」的研究:任何能夠感知其環境並採取行動最大化其成功實現目標的機制的設備。更詳細的是,Kaplan和Haenlein將AI定義為「系統正確解釋外部數據,從這些數據中學習,並通過靈活適應使用這些學習來實現特定目標和任務的能力。」通俗地說,當機器模仿人類與其他人類思維相關的「認知」功能時,應用「人工智慧」這一術語,如「學習」和「解決問題」。

人工智慧的範圍存在爭議:隨著機器越來越強大,被認為需要「智慧」的任務通常會被從定義中刪除,這種現象稱為AI效應。導致Tesler定理中的諷刺,「AI就是還沒被完成的事」。例如:光學字符識別經常被排除在人工智慧之外,已經成為一種常規技術。通常被歸類為AI的現代機器功能包括成功地理解人類語音、在戰略遊戲系統中的最高級別難度、自主運行汽車,以及內容傳遞網絡和軍事模擬中的智慧路由。

人工智慧領域利用計算機科學、信息工程、數學、心理學、語言學、哲學等。該領域的基礎是人類智慧「可以如此精確地描述,可以使機器模擬它。」這引發了關於心靈本質的哲學論證以及創造具有類人智慧的人造生物的倫理。這些問題是自古以來神話,小說和哲學所探討的問題,有些人認為人工智慧如果不斷發展就會對人類構成威脅,另外,也有人認為,與以往的技術革命不同,人工智慧會造成大規模失業的風險。

在二十一世紀,隨著計算機能力,大數據和理論理解的同步發展,人工智慧技術已經成為技術行業的重要組成部分,有助於解決計算機科學,軟體工程和運籌學中的許多挑戰性問題。

歷史

[编辑]人工智慧發展的歷史可說是十年河東,十年河西,早期流行符號學派,也就是所謂的專家系統,詢問專家其領域相關的知識,如詢問醫生怎麼辨別流感及一般感冒?又或是問氣象學家怎麼預測天氣狀況?藉由蒐集到的資訊將其匯入資料庫,提供給機器去判讀。然此種方式在大量收集資料的情況下,可能出現規則衝突的情況,另外像向專家學習也存在經驗、領域知識無法完整傳遞的問題,故晚近則是流行連結聯結派,不同於符號學派採演繹推理的模式,聯結派則是採用歸納推理,允許例外情況存在,並能進行自我學習。

人工智慧的發展歷史中的重要事件紀錄如下表:

| 年代 | 人物 | 事件 |

|---|---|---|

| 17世紀初 | 笛卡兒(René Descartes) | 提出動物身體只不過是複雜的機器 |

| 1642 | 帕斯卡(Blaise Pascal) | 發明第一台機械數字計算機 |

| 19世紀 | 巴貝奇(Charles Babbage) | 提出與製作差分機、分析機 |

| 19世紀 | 勒芙蕾絲(Ada Lovelace) | 發表了第一段分析機的演算法 |

| 1910 | 羅素(Bertrand Russell)

懷海德(Alfred North Whitehead) |

發表了Principia Mathematica,修改了形式邏輯 |

| 1943 | 麥卡洛克(Warren McCulloch)

皮茨(Walter Pitts) |

發表《保留在活動中的邏輯邏輯演算》,為神經網絡奠定了基礎 |

| 1950 | 圖靈(Alan Turing) | 提出圖靈測試(Turing test),用以測試機器是否能夠表現出與人等價的智慧,現今仍然是人工智慧領域相當重要的測試之一。 |

| 1951 | 曼徹斯特大學 | 第一個人工智慧程序,運行於Ferranti Mark I引擎 |

| 1956 | 麥卡錫(John McCarthy) | 首次提出「人工智慧」一詞 |

| 1958 | 發明Lisp編程語言 | |

| 1966 | 維森鮑姆(Joseph Weizenbaum) | 建立了應用Rogerian心理療法的聊天機器人ELIZA |

| 1960s

1970s |

莫塞斯(Joel Moses) | 實施了計算機代數系統的Macsyma計畫 |

| 1969 | 閔斯基(Marvin Minsky)

派普特(Seymour Papert) |

發表了《Perceptrons》一書,展示簡單的神經網絡邊界 |

| 1972 | 科梅侯耶(Alain Colmerauer) | 開發計算機語言Prolog |

| 1970s | 索爾特夫(Ted Shortliffe) | 開發專家診斷系統MYCIN,是最早的人工智慧專家系統之一 |

| 1980 | 莫拉維克(Hans Moravec) | 開發出第一台計算機控制的車輛 |

| 1980s | 維波斯(Paul John Werbos)

霍普菲爾德(John Joseph Hopfield) 魯梅爾哈特(David Rumelhart) 辛頓(Geoffrey Everest Hinton) |

研究神經網絡模型,並運用於反向傳播算法 |

| 1997 | 深藍(Deep Blue)超級電腦 | 利用人工智慧運算打敗國際西洋棋冠軍 |

| 2004 | 美國國防高等研究計畫署(DARPA) | 車輛運用GPS與先進計算機、傳感器跨越數百英里的沙漠 |

| 2016 | AlphaGo | 利用人工智慧計算,打敗世界頂尖圍棋高手李世乭 |

| 2021 | AlphaFold | 利用Graph Neural Network(GNN)來解決蛋白質折疊的問題 |

分類

[编辑]人工智慧系統基本上可以分為三種:

- 分析功能:分析功能的人工智慧具有認知智慧的特徵,它主要是利用過去人類積累的知識和經驗作為基礎再為未來的決策提供信息。

- 人類情感功能:具有情感智力、理解,以及在決策中會加入了人類情感的因素在決策中。

- 人性化的人工智慧:具有認知,情感和社交智慧的特徵,能夠與人在日常交往中表現出獨有的自我意識和個性。

但是,以到目前為止的發展來說,人工智慧與人類智慧還是有很大的差距。儘管AI具有強烈的科幻內涵,但AI構成了計算機科學的一個非常重要的分支,處理機器中的行為,學習和智慧適應。人工智慧研究涉及使機器自動化,需要智慧行為。例子包括控制,計劃和安排,回答客戶診斷和問題的能力,以及手寫識別,語音和臉部。這些事情已成為獨立的學科,專注於為現實生活中的問題提供解決方案。 AI系統經常用於經濟學,醫學,工程學和軍事領域,如在幾個家庭計算機和視頻遊戲軟件應用程序中建立的那樣。這種「人工智慧」不僅要了解智慧系統是什麼,還要構建智慧係統。

從廣義上講,AI分為兩個概念,即常規AI和計算智慧(CI,Computational Intelligence)。傳統的AI主要涉及現在歸類為機器學習(Machine Learning)的方法,其特徵在於形式主義和統計分析。也稱為符號AI,邏輯AI,純AI和GOF(Good Old Fashioned) AI。方法包括:

- 專家系統:運用考慮的能力得出結論。專家系統可以處理已知的大量信息,並根據這些信息提供結論。

- 基於案例的考慮因素

- 貝葉斯網絡(Bayesian network)

- 基於行為的AI:用於手動建立AI系統的模塊化方法計算智慧涉及迭代開發或學習(例如,在連接系統中調整參數)。

這種學習基於經驗數據並且是相關的具有非符號AI,不規則AI和軟計算。主要方法包括:

- 神經網絡(Neural Networks):具有很強模式識別能力的系統

- 模糊系統(Fuzzy control system):在不確定性下考慮的技術,已廣泛應用於現代工業和消費者產品控制系統

- 進化計算(Evolutionary computing):這些方法主要分為進化算法(Evolutionary Algorithm)(如遺傳算法)和群體智慧算法(Swarm intelligence)(如天線);為使用混合智慧系統,進行實驗以結合這兩組可以通過神經網絡或來自統計學習的生產規則來生成參考規則,如在ACT-R中那樣。通過技術加強情報智慧是一種加強情報的方法,試圖在進化過程中實現人工智慧。

強人工智慧與弱人工智慧

[编辑]「人工智慧」這個名詞最初是在1956年DARTMOUTH學會上,由約翰•麥卡錫提出的,代表「人工智慧」這門新興學科的正式誕生。在此我們要討論,從「智慧」的本質上來說,人工智慧是否真正擁有「智慧」呢?也就是說,機器是否能夠做到「像人一樣理性地思考」或「像人一樣理性地做決策」?許多哲學家在探討此議題,而美國哲學家約翰.瑟爾(John Searle)則提出依照人工智慧達成目標的可能性,將人工智慧分為兩種:「強人工智慧」(Strong A.I. 或 Bottom-up A.I.)以及「弱人工智慧」(Weak A.I.或Top-down A.I.)。

強人工智慧(Strong A.I.或Bottom-up A.I.)

[编辑]強人工智慧觀點認為「有可能」製造出「真正」能推理和解決問題的智慧機器,並且這樣的機器將被認為是具有知覺、有自我意識的,甚至可能超越人類。這種觀點被稱為「Bottom-up A.I.」,因為強人工智慧是由下而上主動學習知識,感知和分析情況。強人工智慧可分為兩種類型:

人類的人工智慧:這種類型的機器思考和推理方式類似於人類的思維模式。 非人類的人工智慧:這種類型的機器產生了與人類完全不同的知覺和意識,並且使用與人類完全不同的推理方式。

弱人工智慧(Weak A.I. or Top-down A.I.)

[编辑]弱人工智慧觀點認為「不可能」製造出能「真正」地推理和解決問題的智慧機器,這些機器只不過「看起來」像是智慧的,但是並不真正擁有智慧,也不會有自主意識,這些機器只是遵循著我們人類所制定的條件判斷與運算來執行程式(也就是Top-down)。

以目前的人工智慧的研究進度來看,相關領域的專家已造出許多「看起來」具有智慧的機器,特別是在類神經網絡的發明及研究在人工智慧領域具有相當大的指標性。這些人工智慧已經有相當多的實際應用,但對於要如何將這些整合成強人工智慧,現在還沒有明確定論。

對強人工智慧的哲學爭論

[编辑]關於強人工智慧的爭論,其爭論要點為:如果一台機器的唯一工作原理就是轉換編碼數據,那麼這台機器是不是有思維的?希爾勒認為這是不可能的。他舉了個中文房間的例子來說明,如果機器僅僅是轉換數據,而數據本身是對某些事情的一種編碼表現,那麼在不理解這一編碼和這實際事情之間的對應關係的前提下,機器不可能對其處理的數據有任何理解。基於這一論點,希爾勒認為即使有機器通過了圖靈測試,也不一定說明機器就真的像人一樣有自我思維和自由意識。

也有哲學家持不同的觀點。丹尼爾·丹尼特在其著作《意識的解釋》(Consciousness Explained)裡認為,人也不過是一台有靈魂的機器而已,人可以有智慧而普通機器就不能呢?他認為像上述的數據轉換機器是有可能有思維和意識的。

有的哲學家認為如果弱人工智慧是可實現的,那麼強人工智慧也是可實現的。比如西蒙·布萊克本(Simon Blackburn)在其哲學入門教材Think裡說道,一個人的看起來是「智慧」的行動並不能真正說明這個人就真的是智慧的。我永遠不可能知道另一個人是否真的像我一樣是智慧的,還是說他僅僅是「看起來」是智慧的。基於這個論點,既然弱人工智慧認為可以令機器「看起來」像是智慧的,那就不能完全否定這機器是有智慧的。

需要指出的是,弱人工智慧並非和強人工智慧完全對立,也就是說,即使強人工智慧是可能的,弱人工智慧仍然是有意義的。至少,今日的計算機能做的事,像算術運算等,在一百多年前是被認為很需要智慧的。並且,即使強人工智慧被證明為可能的,也不代表強人工智慧必定能被研製出來。

類神經網路(Artificial Neural Network)與深度學習(Deep learning)

[编辑]類神經網路,又稱人工神經網路,是一種常用且被廣泛研究的一種機器學習演算法。它是一種模仿生物神經網路的數學計算模型。在人工神經網路中,許多稱作神經元的人工節點互相連接,起形成一個類似生物神經網路的網狀結構。近年來類神經網路因為在很多工作上都表現出遠超其他演算法的正確率,所以佔了人工智慧領域的主要地位。

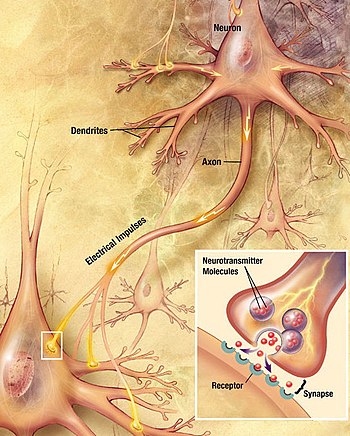

在生物體中,訊息處理與傳遞是由神經元藉由傳遞化學訊號與電訊號來完成的。神經元主要由樹突、細胞本體、與軸突組成,如右圖。一般情況下,訊號在一個神經元的傳遞過程是由樹突接受刺激起始,將訊號傳到細胞本體分析後,最後由軸突傳出。在複雜的神經傳導路徑中,可能涉及許多層的神經元,這時前一個神經元的軸突末端會在稱為突觸的位置釋放化學分子,將訊號傳到神經元的樹突,並開始在下一個神經元的訊號傳導。

我們通常在圖上以一個「節點」來代表人工神經元。如下圖,人工神經元會接受許多輸入,這些輸入可能是來自前一層神經元,藉由突觸傳導過來的。因為每個輸入所佔的的影響比率有所不同,必須要對它們進行加權,我們指定給每個突觸一個權重,而最終期望得到一個加權總合。在神經元本體中,會將個總和加上一個起偏值後,得到,這個值稱為「啟動值」。而繼續經由一個活化函數的作用後,即產生輸出值。

下表整理了生物神經元與類神經元的功能對應關係:

| 生物神經元 | 類神經元 |

|---|---|

| 樹突 | 輸入 |

| 細胞體 | 啟動與活化 |

| 軸突 | 輸出 |

| 突觸間隙 | 權重 |

感知器

[编辑]類神經網路發展出的第一個應用實例為1957年由Frank Rosenblatt所發明的「感知器」,這個類神經網路僅含有一個「輸入層」與一個輸出的神經元,也就是多輸入單輸出的神經元。雖然感知器有很強大的效用,不過不久後就被證實它只能用來學習出「可線性分離」的模式,因為活化函數值只與啟動值有關,而又是一個輸入值的線性函數。一如Marvin Minsky與Seymour Papert所指出,此模型無法學習出XOR的基本運算。感知器的活化函數通常遵守神經動作電位的全有全無律,以數學式精確定義如下:

感知器有計算快速、易於解釋、方便使用等優點,因此常用在只需要得出離散結果的模型,如滿意度調查、商品選擇與候選人投票結果等。但是因為它只能用來處理可線性分離的資料,所以適用範圍其實非常侷限。雖然如此,感知器在人工智慧的發展歷史中仍然佔有很重要的角色。

多層神經元網路

[编辑]以上所介紹的感知器又稱為「單層前饋式神經網路」。「前饋式」是指訊號沿著神經單向傳遞,只會從輸入層傳向輸出層;而「單層」則是指輸入層後方只有一層輸出層。很快的我們發現,可以從感知器的模型往後繼續做推廣。例如可可以由同一組輸入根據不同的加權值產生許多輸出,亦即輸出層有許多神經元,但這還是在單層網路的線性範圍內。同時如果將這許多的神經元輸出值,又當作下一層神經元的輸入值,則我可以構造數層神經網絡,如下圖所示。

更精確來說,我們可以定義為「第層的第個神經元」與「第層的第個神經元」之間的權重。若我們將所有層的輸入與輸出寫成向量形式,那麼層與層間的權重就可以用一個矩陣來表達。如下述的表示法:

第層的輸入寫為 第層至第層的起偏值寫為 第層至第層的權重寫為 那麼就有以下關係式:

我們將第一層稱為輸入層,最後一層稱為輸出層,而中間數層稱為隱藏層。由於經過一層的神經元進入下一個神經元的過程中,會經過「活化函數」的作用,如果這個活化函數是非線性函數,則我們就可以擺脫感知器的限制,實現非線性的分類。事實上,「一般定理(Universal approximation theorem)」指出了,任何一個函數都可以利用至少一層(寬度不受限)的類神經網路來無限逼近。

研究課題

[编辑]目前人工智慧技術的研究課題主要是利用計算機和機器,通過複雜電腦運算程式來模仿人類的智慧技術。而模擬或創建智慧技術可以分為不同領域,以下描述的領域是比較多人關注:

- 演繹、推理和解決問題

- 知識表示法:知識表示法的目標是讓機器儲存已知和相關的知識,並且按照某種規則去推理和演繹從而得到新的知識。已知和相關的知識包括事先儲存的先驗知識和通過智慧推理得到的知識。事先儲存的先驗知識是指:人類通過某種方式儲存在機器的知識。通過智慧推理得到的知識是指:結合先驗知識和某種特定的推理規則「邏輯推理」而得到的知識。目前知識表達法有許多困難尚無法解決,比如:由於資源限制,建立一個完備的知識庫幾乎不可能;先驗知識庫的準確性需要事先進行檢驗,而且先驗知識有時候不一定是只有對或者錯的兩種情況。

- 規劃:人工智慧的核心智慧必須能夠制定目標和實現這些目標。核心智慧以數學模型建立一個可預測的世界模型,並以這模型來預測將來可能發生的事情,同時提供最好的方案予決策者選擇。

- 學習:機器學習是讓機器從使用者和輸入數據等地方獲取知識,從而讓機器自動地去判斷和決定如何運算,最後再輸出相應的結果。以下分別詳細介紹機器學習的四種分類以及學習步驟流程。

機器學習的流程大致上可歸類出以下依序七個步驟:

- 收集資料

為了便於理解,假設我們要訓練機器判定一杯酒是啤酒還是葡萄酒。在機器學習之前,我們必須選定哪些指標作為判定依據。這一步驟非常重要,因為它直接影響訓練機器的效率和準確性。以本例為例,我們可以選擇顏色(變數 x)和酒精濃度(變數 y)等指標,然後設置相關測量設備來收集這些數據。

- 準備數據

在取得相關資料後,我們就可以開始整理欲輸入機器的資料了。在這裡要將數據分成兩組,第一組資料是用來訓練機器(第4步驟),使機器具有判斷分析能力。第二組資料是用來測試訓練出來的成果(第5步驟),用來評估模型的合適性。同時,在這裡我們應該也要簡單判斷一下輸入的數據是否恰當,比如說,如果用來訓練的數據啤酒佔了大多數,而葡萄酒只有少數幾杯時,那麼可能會造成訓練出來的結果會使判斷過度偏向於啤酒。 - 選擇模型

依照輸入與輸出資料模式的不同,我們也應該要選用不同的模型來作學習。機器學習有許多常用的相關演算法,在不同情況時可以妥善的選擇運用,常見的三種學習模式在下一個部分會詳述。如在本例中,我們就可以使用有關分群的演算法來解決問題。更精確來說,我們設計的模型可能是,當 mx + y + b > 0時判斷為啤酒,而當mx + y + b < 0時判斷為葡萄酒,其中m和b為未知的參數,將在下一個步驟決定。(x為顏色,y為酒精濃度)當然此模型不一定是好的,在這裡只是舉例說明而已。 - 訓練機器

這部分是機器學習的重點關鍵步驟。在上一步驟選用的模型中,有許多參數(如m和b)是還未決定的。在此步驟中,我們會將第2步驟準備的數據輸入機器,並經由上述模型的判斷結果與正確結果進行比對,如果比對結果不佳,就應該調整模型中的參數。在經過一次又一次的重新判斷、比對並修改參數的過程中,會使判斷的正確率逐漸提高。如果比對的正確率一直不如預期卻也不再上升,那麼可能是上一個步驟選用的模型不夠好。 - 評估分析

當機器訓練至正確率不再提升、或者已經達到足夠的正確性時,就可以將第2部分準備好的測試數據拿來檢驗機器訓練的成果。畢竟若訓練結果與學習數據非常擬合(甚至可能會有過擬合的狀態出現),也不代表對於其他的數據也適用。這時候就需要用額外的數據來做檢驗,若不適用,則重新回到選擇模型之處。 - 調整參數

若此學習成果評估之後視為可被採用,那麼我們可以繼續給予更多的數據始之學習,可以對參數做一些更精確的微調。 - 預測推論

經過以上重重的步驟,最後我們的機器就有一定的判斷能力,可以依照數據來預測或者推論結果了。

學習模式

[编辑]機器學習依照學習以及輸出模式的不同,分為三個類別:監督式學習、非監督式學習、強化式學習。

- 監督式學習(supervised learning)

在這種學習模式中,我們會先為準備的學習資料(數據)進行「標籤化」的程序。這些標籤就像標準答案,訓練過程中判斷的結果可以和此標準答案進行比對,以修正參數取得正好的正確性,因此一般來說監督性學習的準確率是較高的。不過監督式學習在收集資料以及準備數據的程序上需要耗費較大的人力,所以面對未知領域時會遇到瓶頸。

舉例來說,上述「分辨啤酒與葡萄酒」即是一種監督式學習,因為提供給機器學習的數據中有標示哪些是啤酒、哪些是葡萄酒(標籤)。另外常用的例子如分辨垃圾郵件的工具等,可以使用監督式學習的方法來實現。 - 非監督式學習(unsupervised learning)

在非監督式學習中,提供機器學習的資料不必以人工加上標籤。機器會依照演算法來尋找資料的共通點,依照「物以類聚」的特性加以分類,但機器本身並不知道分類結果是否正確。由於不須加上標籤的特性,使它成為資料探勘初期的好工具,且能大幅減少人力需求。不過缺點是,非監督式學習的功耗較大,且正確率較監督式學習低,且可能造成非重點特徵被過度放大。聚類分析(Cluster analysis)是最常見的一種非監督式學習,且在其中K-means是最常用的演算法。

而監督式學習與非監督式學習的差異比較:

監督式學習所需的資料是有固定答案的,就像我們看到照片,一眼就可以說出照片中的物品名稱。在此學習模式下,辨識後的資料會分成連續資料、離散資料以及分類資料,再以個別定義賦予回歸、分類、預測功能,而線性/邏輯回歸、神經網絡,便是這些功能常用的演算法。

非監督式學習所需資料沒有固定答案,依據相似度進行分類,例如:一堆不知名的黑色物品跟白色物品,會下意識依照同顏色做分類。也因為資料答案尚未得知,需要用不同預測功能來分類,比如:依照相似度做區分的聚類功能、以日常行為來預測的推薦系統、或是刪減資料相關度低 的降維。

- 增強學習(reinforcement learning)

在強化式學習中,我們不需要給機器任何的資料(但需要提供機器互動的模擬環境),機器會透過與環境的互動中去學習,這也是接近人類最自然的學習方式。

強化學習的一個經典理論是「馬可夫決策過程」。在過程中,機器會藉由現在的狀態轉移成下一個狀態。若轉移的過程使得與目標距離更接近,則會得到一個正向回饋,若與目標距離更遠,則會得到一個負向回饋。雖然我們不會明確地將每一步的好壞標籤化讓機器讀取,不過它會根據反饋的好壞,逐漸修改內部的參數,最後得到有效力的結果。

以下棋來舉例,我們可以設定一些參數,由這些參數可以計算棋盤狀態的回饋函數。如果此狀態與贏棋的狀態越接近,就回饋越高的分數,機器則會選擇使接下來分數最高的步數來下。那麼我們只要利用兩組不同的參數的機器互相對弈,就可以根據輸贏的結果慢慢調整參數,使勝率提高。如此一來,我們只要告訴電腦基本的規則,則可以讓其依照自我對弈的過程中,找出勝率最高的下法。

雖說增強學習不需要任何資料,但增強學習目前是這三種學習方式裡面效率最差的。以最常見的訓練機器玩 Atari 小遊戲為例子,如果我們用最單純的增強學習演算法來訓練的話,機器通常需要玩一個遊戲數以萬計次才能達到人類中位數的表現。相較之下,人類通常只需玩個 10 ~ 20 次就可以上手。

以上介紹的三種機器學習模式,是根據他們的「學習風格」來做分類的。我們也可以根據實作的方式不同,而將這些實踐學習的演算法分類。以下列出並簡單介紹幾種常見的機器學習演算法。

- 線性迴歸 (Linear regression)

線性迴歸是統計學和機器學習中最知名的算法之一。

機器學習中,我們對於每一組輸入變量(X),都決定一組輸出變量(Y),機器學習的目標就是量化輸入變量與輸出變量之間的關係。在線性迴歸中,會假設輸入變量(X)和輸出變量(Y)之間滿足Y = a + bX這個線性關係,並找出係數a和b的值,(其中a是截距,b是線的斜率)。

更一般來說,設輸入變量為隨機樣本,線性迴歸的目標就是要找到一組參數,使得在與的關係中,(或稱為誤差項)的平方和最小,即最小。此方法稱之為「最小平方法」。 - 邏輯迴歸 (Logistic regression)

線性迴歸預測是連續值(例如以cm為單位的降雨量),邏輯回歸預測是應用轉換函數後的離散值(例如學生是否及格)。Logistic迴歸最適合二進制分類(y = 0或1的數據集。例如:在預測事件是否發生時,發生的事件被歸類為1,未發生為0)。它以其中使用的變換函數「邏輯斯函數」命名,數學式寫為,它是S形曲線。 - 決策樹(Decision tree)

決策樹是由許多決策節點構成,每個節點均有檢察某特定屬性的變量,而「葉節點」,即最終端的節點,則是表示目標變量之值。決策樹是一種分類器,從根節點開始,逐步向葉節點移動,即可達成分類的效果。生物分類法的分類樹即為一例。 - 集群演算法(K-means )

集群演算法是一種非監督式學習的機器演算法,而最常見的集群演散法即為K-means。此演算法的目的是要將所有樣本分類至k個不同的子集群之中。我們以下列的順序來達成此演算法的目的:首先,隨機選擇k個點,接著對於每個質心,都找到與其距離最近的點,並將這個點與質心結合為一個群組起來。此時我們從新計算每個子集合的中心點,並將此中心點重新定義為此集合的質心。接著重複以上步驟(找最近的點、重新定義質心),直到質心不再移動為止。

實際應用

[编辑]下面介紹幾個人工智慧的實際用途。

- 自然語言處理

- 自然語言處理(Natural Language Processing,又稱NLP)是人工智慧和語言學領域的分支學科,在於探討如何處理及運用自然語言。自然語言處理包括多方面和步驟,基本有認知、理解、生成等部分。自然語言認知和理解是讓電腦把輸入的語言變成有意思的符號和關係,然後根據目的在處理。自然語言生成系統則是把計算機數據轉化成自然語言。

- 用途:

- 在許多情況下,學者們需要通過許多不同的資料庫來確定新的研究方向,以識別研究差距並確定迄今為止尚未研究的領域。檢查所有的資料庫很麻煩,而且經常會遺漏重要的部分。通長會使用網路抓取和自然語言處理來縮短識別研究差距所需的時間。

- 在Google學術搜尋上索引的出版物的標題, 自然語言處理標記化(Tokenization)從最高頻率到最低頻率對搭配進行排序。因此,自然語言處理標記化(Tokenization)確定了標題中未提及的關鍵字集,並將最初的想法確定為研究空白。

- 自然語言處理的難點:

- 單詞的邊界界定:在口語中,詞與詞之間是連貫的,而界定字詞邊界通常使用的辦法是取用能讓給定的上下文最為通順且在文法上無誤的一種最佳組合。在書寫上,漢語也沒有詞與詞之間的邊界。

- 詞意的消岐:許多字詞不單只有一個意思,因而五們必須選出使句意最為通順的解釋。

- 句法的模糊性:自然語言的文法通常是模稜兩可的,針對一個句子通常可能會剖析出多棵剖析樹,而我們必須要仰賴與語意以及前後文的資訊才能在其中選擇一棵最為適合的剖析樹。

- 有瑕疵的或不規範的輸入:例如語音處理時遇到外國口音或地方口音,或者在文字的處理中處理拼寫,語法或者光學字元識別(OCR)的錯誤。

- 語言行為與計畫:句子常常並不只是字面上的意思。例如:「你能把鹽遞過來嗎?」,一個好的回答應當是動手把鹽遞過去。在大多數上下文環境中,「能」將是糟糕的回答,雖說回答「不」或者「太遠了我拿不到」也是可以接受的。再者,如果一門課程去年沒開設,對於提問「這門課程去年有多少學生沒通過?」回答「去年沒開這門課」要比回答「沒人沒通過」好。

- 感知

- 機器感知是指能夠使用感測器所收集的數據,然後推斷外在環境的狀況。

- 防治傳染病

- 人工智慧系統在預測流行疫情爆發方面被廣而利用,醫學流行病學人工智慧系統可以提前三個月凖確預測登革熱疫情爆發,凖確率達到 88% 左右。在醫學領域,以瘧疾為例,過去一旦醫院收到疑似病例,需將影像檔送至疾管署,以人眼判讀是否感染,現在得益於人工智慧的輔助,經過半年多的訓練,電腦判讀惡性瘧原蟲準確度超過9成,未來有望建立瘧疾血片資料庫。

- 由於人工智慧的發展,未來也有望能夠使用完善資料導入大數據分析,使人類對於流感的預測能夠更為準確。[1]

- 應對槍械暴力:有一種自動化系統利用傳感器監聽槍聲(ShotSpotter),然後精確計算槍聲所在的位置,並在 45 秒內向相關機構發出警報。機器學習技術被用來確定聲音是否是自動武器槍擊聲,並計算出它們的數量,從而幫助警察確定他們要對付的是獨行槍手還是有多名槍手。

- 預防饑荒:研究人員與植物病專家合作開發了一套人工智慧系統用於消滅木薯疾病。Mcrops項目允許農民使用智慧手機拍攝植物,並使用經過訓練的計算機視覺來檢視造成木薯作物損害的四種主要疾病的跡象。

- 控制電力應用:研究人員正在開發機器學習運算法,以實時監控能源生產和需求。這樣做當需求處於低位時,能源可以儲存起來,然後在高峰的時候再釋放出來。隨著電動汽車和電池越來越普及,這項技術可以利用這些設備儲存能源,並消除可再生電力供應不穩定的問題。

- 商業應用:將人工智慧技術與商業智慧結合能夠為商業活動帶來巨大經濟利益,包括作業的高精準度、改善決策、降低風險、節省勞動成本、提高安全性、提高操作效率進而提升營業額。

- 舉兩個例子,第一個例子為智慧法遵分析,AI能夠建構法規資料庫及自動分類法規,並監管有異動的規範,達到自動、即時及精準監控的效果,也能夠藉由比對找出相關法規及提供建議,大幅降低法遵成本。

- 第二個例子為美國新創保險科技公司Lemonade,此公司將過去由保險業務員負責的工作由AI取代,把販售保單與客戶理賠的過程都交給保險業務智慧機器人來執行,大幅縮短處理時長及解決繁瑣程序的問題,此外,也透過機器學習分析並判斷適合顧客的保險金額及類型,節省人力成本,Lemonade結合AI機器學習技術與商業活動,成功成為保險科技公司的典範,甚至勝過其他傳統保險公司。

- 醫學診斷上之應用:人工智慧於醫療上的最大應用,也是相較於人類最大的優勢,即是數據分析。而依照數據分析的資料特性又大致可分為以下四個不同的種類:

- 編碼資料:有許多醫療相關的資料都經過標準編碼,且經過編碼過的資料,對於電腦而言知識密度最高,且最容易使用。如台灣在健保制度下的電子病歷即是一例。

- 影像資料:利用人工智慧來進行醫療檢查的相關影像資料,將可以有效減低醫師的負擔,並且AI在影像判讀的速度與正確率都漸漸追上人類甚至優於人類。事實上,在2015至2016年間,荷蘭Radboud大學醫學中心的團隊已由實際測試證實,以深度學習演算法訓練的人工智慧來診斷乳腺癌組織切片中淋巴結的轉移,其正確率與專業的病理學家相當。台灣因健保給付而減低醫療檢查的成本,使醫療檢驗成為家常便飯,所以若使用AI來處理大量影像資料,也可減少人為判斷疏失的風險。

- 自由文字:指人類使用的語言,包含語意、文法,以及前後文的呼應。這些自然語言處理的技術,已經有許多成功的例子,如Siri、Google Home等,而在醫學領域的代表則為能夠輔助癌症診斷的IBM Watson,它已經進化到能夠幫人類讀文章。而值得注意的是,中國科大訊飛開發出的AI機器人「小易」高分通過2017年臨床執業醫師的筆試。此機器人是藉由「多語意深度學習」的方法自主學習並理解題目,利用推理判斷能力來解題,並非使用題海戰術。此能力能夠使機器人學習各種臨床醫學資料,建立完整的醫學知識庫。

- 生理訊號資料:近來的發展趨勢是希望能利用各種穿戴式裝置,來持續的長時間收集病患的心跳、血壓、呼吸等生理資訊,這些大量的資料會由AI進行有效率的分析。此為人工智慧與物聯網的結合應用。

- AI 在醫療照護上,最終的目標是要達到精準預測以及精準預防。以目前的醫療實況來說,往往是「只看疾病不看個人」,但因為年齡、性別以及個體上更基本的差異等也會影響到特定治療方法對於個人的療效不同。不過若要將這些種種因素全部考慮進來,對於人腦來說幾乎是無法辦到的,於是需要AI的輔助下才有可能完成。我們希望AI針對某些問題能夠提供醫師客觀理性的協助,或者評估某疾病的發生率甚至預後分析等,這將會對醫療方面有莫大的幫助。越來越多疾病的診斷在大數據的統計下可以比醫生人為的判斷更為精確,也可以在各種主訴中尋找交集,找出最可能患病的原因。2014年《神經學》期刊在一篇探討「帕金森氏症診斷準確率」的研究論文提出,從過世的帕金森氏症病患大腦解剖,回頭檢視生前醫師給他們下的診斷,在病人剛發病時,只有26%醫生下了正確的診斷;再經過3、5年,看病人的神經反應、行為、對藥物的反應,診斷正確率可以達53%;拉長到8年、10年,準確度可以超過85%。其中人工智慧在醫學上最出名的應用是一台叫做「Watson」的機器,利用其精密的數據分析及計算器巧,可以幫助人類對於資訊的取得更易理解和方便。另外IBM的Watson AI(人工智慧系統)可以分析圖像,並評估病人的診斷書,從而凖確地識別出腫瘤病例,凖確率高達96%。但是此醫學應用之於人類的接受度還是個未知數,畢竟其作為醫生還是少了人性化的部分,但其作為醫學輔助器具想必會是個很大的突破。

- 語音應答

- 人工智慧其中一個研究重點就是使機器能直接用人類語言與人類溝通,這是有一定難度的。首先機器要先能具備辨識語音的功能,再來還要能理解一段話的意思,最後產生符合當下情況的應答,還要能將這個應答轉為人類語言。由於人類對語言的延遲非常敏感,所以上述程序需要被處理得相當迅速;另外,人類自然對話會講得十分快速、不清楚,以及同一句話會因為上下文的不同而有不同意思等等,種種因素都讓機器與人類對話非常困難。

在2018年,Google在其發表會上展示了Duplex,其可以為用戶打電話給餐廳、髮廊的真人店員進行預約、訂位,而且兩家店的店員都沒有察覺到與他們對話的是一個機器人。在髮廊的預約電話中,當店員說請稍後一下時,Duplex回應了「嗯哼」,並等候店員幾秒,這證明了Duplex可以了解對方語意,並使用似真人的應答模式;而且在Duplex欲預約時刻客滿的狀況下,Duplex給出了一個時段,讓店員選出一個有空的時間。而在餐廳的預約電話中,店員說毋需預約,Duplex不僅了解語意,甚至還主動詢問了餐廳等候的時間。

Duplex的功能還只限於替用戶預約時間,但是它的出現告訴了我們,實現真正機器與人類的自然對話不是不可能的;但這也產生了倫理道德爭議,人類其實不願意自己在不知情的狀況下與機器對話,以及在對話中雙方的地位與責任究竟要如何區分,還需要仰賴大眾廣泛的討論。

- 人工智慧其中一個研究重點就是使機器能直接用人類語言與人類溝通,這是有一定難度的。首先機器要先能具備辨識語音的功能,再來還要能理解一段話的意思,最後產生符合當下情況的應答,還要能將這個應答轉為人類語言。由於人類對語言的延遲非常敏感,所以上述程序需要被處理得相當迅速;另外,人類自然對話會講得十分快速、不清楚,以及同一句話會因為上下文的不同而有不同意思等等,種種因素都讓機器與人類對話非常困難。

- 影像處理

- 過去修圖軟體已可輕鬆移除靜態照片內不想要出現的物體,然而這項工作換到影片處理上,立刻變得繁雜而且得不到好的效果。原因在於影片是由數百甚至數千、數萬張的影格組成,即使每個影格單獨處理過,播放時仍可看見明顯的編輯痕跡。然而利用深度學習的技術,電腦可以猜測被選取物體背後之像素,並自動進行移除與填補修復。這項技術在Adobe Max 2017活動上展示的Project Cloak中可以看到十分完美的成果。這項功能提供了未來電影工作室一個更有效率的影片合成的選擇,也讓修改影片更輕鬆而且看不出痕跡,然而是否會被有心人士拿來做不法用途,則是另一個隱憂。[2]

- 臉部識別(Face perception)

人工智慧與認知心理學之間的關係

[编辑]人工智慧(AI)研究機器的認知。而 AI 的目標,其中之一就是運用計算機實現人類的智能。

如今,人工智能在運算方面已經遠遠強於人類,然而,「智能」牽涉到的不僅僅止於運算,而是包括了意識(Consciousness)、自我(Self)、思維(Mind)(包括無意識的思維(Unconscious mind))等問題。因此,對人類智能的理解亦是與人工智能習習相關的研究課題。此外,相關科學家也利用認知心理學去理解人工智慧的思考邏輯,以下是近期的例子:

DeepMind 研究團隊利用理解兒童的方式來理解人工智慧──透過對兒童的認知心理學測試試圖理解 AI。研究團隊發現 AI 擁有與人類孩童相同的偏好,它們更喜歡透過形狀而非顏色對物體進行分類。這是首次將認知心理學引入深度神經網路的研究。可見人工智慧與人類的認知有著密不可分個關係,兩者的研究也能相輔相成。

- 如何解讀 AI 的思考

- 在機器學習中,工程師先是編寫了類似原始大腦的神經網路,再透過給予大量數據來進行訓練,機器則從中學習辨別與理解,就像大腦運作的方式一樣,也因為如此,AI「思考」的方式人無法理解。這個困境工程師稱之為「可解釋性」問題,而神經網路則稱為「黑盒子」──你可以刺激並觀察,但無法理解內在。身為現今最知名 AI「AlphaGo」的開發者,Alphabet 的子公司 DeepMind 研究團隊也希望解決這個問題,因此決定用一個全新方式來了解 AI:就像對待人類的孩子。這並不是一個比喻,DeepMind 的研究科學家 David Barrett 表示,團隊正在使用和心理學家用在孩子身上的認知心理學技術及測試,來試圖了解 AI 的想法。Barrett 認為,認知科學對人腦的研究已有數十年,如果應用到機器的過程順利,將能理解 AI 的思考模式,並為它的決定負責。在研究中,DeepMind 至少已理解了 AI 的一種學習模式:一次性學習思考。這個設計原先是用來讓 AI 看過一次項目後,就學習單字的意思,DeepMind 意外發現,AI 解決這項問題的方式和人類相同,是透過形狀來辨別物體。研究人員發現,即使沒有著指導,也存在著許多方法來識別隨機對象,像是顏色、質感及行為模式,AI 卻是選擇像人類一樣用形狀來識別物體,這樣的行為模式是以前未曾察覺的。

- 機器人心理學

- 類似這樣對 AI 思考的理解只是開始,就像人類心理學一樣,機器人心理學未來也可能發展出一種「治療」行為──也就是去改變 AI 的心態。工程師在創造 AI 時,經常會選擇創造多種版本,以便於從中找出最好的來使用,Barrett 認為,透過認知心理學的應用,工程師可能會更容易創造出「想法」符合人類需求的 AI。又或者,我們也可能從中發現,AI 的思考模式與人類有所不同,人們或許能從中學習到一些新的東西,像是該如何解決一些問題。在用人工智慧取代人類決策者時,我們總是希望機器做得更好,犯更少錯誤並承擔責任。當 AI 的產出能被衡量,人們或許就能夠追蹤它們做決定背後的過程。在現今法庭中,我們總是由人來解決商業問題上的爭執,如果改由機器取代人力,我們或許就能夠觀察到「決策者」在過程中的心態轉變,與所有可能出現的偏見。

爭議

[编辑]融合了deep learning和fake兩個單字,是一種人像產生的AI程式,其原理是利用給定的人物特徵,將其合成到目標影片或圖片上。這項技術相當方便,有相當廣的運用。

NVIDIA在2018年公布了多項研究成果,如:

- Image Inpainting可將圖片缺損的地方自動補起來,就算是人臉雙眼都被塗掉,仍可以將圖片修復為自然的人臉,或是它也能將圖片中我們不想要出現的東西修掉。

- vid2vid這項技術可將草稿影片與圖片輸出自然的成品,如輸入的影片只是線條勾勒的人臉在說話,vid2vid可以自動將其填入顏色與細節,生成一個自然的人在說話,而我們也可以進行顏色、氛圍的調整。[4]

- Style-Based Generator不同圖片視為有不同的風格,在不需要人類參與訓練過程的情況下,可以將兩張不同人像,個別選擇不同的特質以供合成,甚至可以微調各項參數特質的強度,比如說頭髮的捲度、人像角度、年紀、性別等等。

- 我們知道影片其實就是多張圖片連貫放在一起,一秒鐘有幾張圖片我們稱之為幀數(fps),幀數高影片就流暢,反之則不流暢。將影片速度放慢其實就是把換下一張圖片的時間拉長,因此幀數會下降,所以影片放慢是有極限的。Super SloMo則是將一段影片中再插入新的影像,參考的是前後幾張圖片,在中間生成一張新的圖片,由此我們可以將一段影片的幀數提高,再將其放慢,就可以生成高品質的慢動作影片。[5]

- 很多人在使用電腦的時候會將前鏡頭貼起來,一來是因為不常用到這項功能,二來是為了前鏡頭可能會受到駭客攻擊而進行遠端監控,而研究人員發現,電腦或是手機隨附的麥克風竟然也可以用來監控用戶的行為,利用螢幕的電流噪音,配合上該廠牌螢幕的顯示原理,便可以透過錄音分析出螢幕上顯示的內容[6]。其研究目標是將螢幕軟鍵盤按下的字母還原至以下十八個區間內:'b’, ‘c’, ‘m’, ‘n’, ‘p’, ‘v’, ‘x’, ‘z’, ‘aq’, ‘sw’, ‘de’, ‘fr’, ‘gt’, ‘hy’, ‘ju’, ‘ki’, ‘lo’, 和空白鍵。研究結果顯示,使用高階麥克風錄音重現螢幕上的文字準確率達100%,而手機的麥克風錄音的準確率也可以達97%。

這些技術若遭到濫用,很明顯的影響不只是個人,有心人士可以從中牟利,可以是金錢上的獲利,乃至政治上、國家安全上的問題,因此AI可以幫助我們是一回事,但要怎麼預防AI犯罪又是另一回事了,或許在科技發展的同時,我們也要想好因應策略才是上上之策。

貧富差距、失業

[编辑]自人類發展的歷史來看,每當一項改革性的技術大規模應用時,許多職業會面臨被取代的危機。目前AI的其中一個目標就是達到真正的自動化,由AI自行判斷在流程上可能會遇到的問題並自行修正解決,如自駕車技術的出現。目前各科技與汽車大廠紛紛參與開發自駕車,如此一來許多以駕駛維生的人會面臨到失業的問題,例如計程車司機、公車司機等等,或是近年流行的食物、生鮮外送也會被取代掉。除了司機可能會被取代以外,許多能夠被拆解成重複、離散的工作,包括律師助理人員、記帳人員等等,透過自動化,減少了對行政技能的需求,這些工作就會慢慢消失。也許多種新的就業方向將產生,不過新技術的出現代表產業入門門檻很可能會比原工作更高,無法適應的人類就會面臨失業,可能導致階級分化更嚴重。

錯誤及偏見

[编辑]就如人一般,機器不可能是完美無缺點的,正常運作時可能不會產生問題,但若有人刻意破壞「正常情況」,便有可能為其所利用。例如研究者發現,如果在語音辨識系統中輸入特定噪音,就能夠改變翻譯結果,甚至讓機器說出特定的語句;另外,現今AI幾乎都是用機器學習來訓練模型,所以開發端給什麼資料,這個模型就會偏向資料的特性,因此開發者可能無意識中將人類有的偏見也帶入該AI模型中,而人類又偏向相信電腦不會偏袒任何一方,比如說罪犯預測系統,可能會因為提供的資料很多都是某個人種,最終訓練出的AI會對此人種有「歧視」的情形。

因此,在進行機器學習時,研究員可以針對一個已經成熟的演算法給予其「對抗例」。「對抗例」指的通常是一種人為設計的問題,去挑戰一個演算法是否是完備,還是可能仍不夠完善,僅能回答原本建構這個演算法時的那些問題。例如一成熟演算法可以判斷「照片中的動物為何種動物」,「增加人為雜訊且不影響人類判讀的照片」即可視為一對抗例,若獲得了錯誤的答案,可能演算法就需要修正。過去的一項研究中,機器學習要訓練虛擬的人A在另一人B的阻止下移動至對面,而A最後訓練出來的方法卻是一開始要向前傾去抵擋B阻擋的推力,因此後來研究員給予一「對抗例」即B只會站在那裏不動時,反而A會直接向前傾跌倒,這個對抗例即呈現了這個演算法不夠成熟。

為了避免這樣的問題,我們需要更加仔細的檢視我們給予機器學習的資料豐富程度是否足夠代表該任務,或者學習的方式是否會導致成果非常局限於只能處理我們提供他練習的問題。

倫理

[编辑]由於現今的人工智慧幾乎都是基於類神經網路的想法,其佔了人工智慧領域的主要地位,數據輸入後,會進行非常大量的運算,因此我們很難知道機器如何處理數據;再者,因為在實驗室或實驗場的控制條件下,常常情況就是非黑即白的,但是現實生活中並不是如此,通常沒有絕對的對錯。

若電車問題發生在自駕車行進的過程中,由於我們不清楚機器如何運算,因此我們也沒辦法預先知道機器會做出甚麼選擇,且機器在訓練過程中可能沒有這種資料,當問題產生時,究竟責任是在於誰,是工程師?是汽車製造商?是在車上的駕駛員(乘客)?還是被撞到的人事物?光是責任釐清就非常困難了,再加上可能會有人產生自駕車究竟有沒有權力代替人類行駛的疑問等等,都還需要相關專家與大眾進行討論與改變。

此外,若是醫學機械手臂在操作手術時發生失誤,包括突發性斷電、機器人碎片掉入患者體內等,或是在診斷病人病情時出現誤判,前者嚴重時可能造成患者死亡,後者則可能將誤導治療方向,對病人而言都是不可挽回的錯誤,此時相關的賠償及責任歸屬也不易判斷,在此議題被解決或是成立相關法規前,即便機械手臂的高穩定性可以省下醫護的負擔,大多時候也能達到精準醫療的效果,大眾卻仍會對此技術存有疑慮。

過去也曾經發生過紐澤西竊盜案件,當時警方利用人工智慧的人臉辨識系統企圖逮捕犯人,卻因為嫌犯與一名民眾的五官過於相似,而發生人工智慧鑑識錯誤將兩人的臉搞混,進而使警察抓錯人。雖然將人臉辨識應用在抓捕犯人上能夠省時省力,一般而言錯誤率也較低,然而一旦發生誤判,對無辜的人民而言卻帶來相當大的迫害,例如案例中的無辜男子便因此被當成代罪羔羊做了幾年牢,嚴重侵害他的人身自由權。此外,將全民的臉部儲存在警政系統也可能有隱私的疑慮,甚至若是通緝犯做了整形手術,人臉辨識系統便無用武之地。因此,在真正應用之前仍須經過嚴謹的測試。

資料取得來源與過程的爭議

[编辑]在人工智慧進行資料探勘及學習的過程中,需要提供機器大量的數據。以醫療方面的應用為例,我們希望能夠藉由這些資料研發出協助醫師處理資訊及診斷的人工智慧。而數據的取得來源與過程,不可避免的引發了一些爭議,特別是利用病患的生理數據來進行研究、甚至研發商業產品的情況。以下整理了幾個代表性的案例。

第一個案例是Google DeepMind為了測試一個用來測量腎臟健康狀態的APP,而收集了倫敦皇家自由醫院的160萬條患者的診療紀錄。英國當局認為此行為違反「患者隱私法」,而這個事件後來也被BBC報導出來。

第二個案例與著名的Hela細胞系有關。1951年約翰霍普金斯醫院的醫師從患有子宮頸癌的女子Henriatta Lacks的子宮頸收集細胞並培養,最後變為世界上第一個永生細胞系。此細胞系後來在實驗上被廣泛的研究,但是她的家族並無得到任何補償,且在Henriatta Lacks去世20年後才知道這件事。雖然2013年NIH與其家人已達成研究相關的協議,不過她的家人仍然對此事耿耿於懷。

第三個案例仍與活體組織培養有關。1976年John Moore於加州大學洛杉磯分校接受白血病的相關治療,醫師在治療過程中因為想要研究某些現象,從他脾臟取出的細胞建立了一個細胞系,最後他的細胞甚至被用做商業用途,然而這件事並不為Moore所知。雖然不可否認的,醫師對於Moore的白血病做了相當良好的處理,不過在1990年Moore得知此事後仍然決定起訴。法院認為Moore雖不擁有醫師創建的細胞系,但醫師有義務將此細胞系的相關研究以及商業用途告知Moore。最後Moore與其醫師在庭外達成和解,不過Moore仍有被欺騙的感覺。

接下來是這些案件的倫理討論。資料取得的相關倫理爭議,主要是基於「科學研究成果或商業價值」與「患者權利」之間的衝突。有一派的觀點認為,對於患者來說,無論是活體組織或者是生理數據都屬於這個人的相關信息。雖然這些數據是醫師所創造的,但與患者之間的直接關聯性是不能被忽略的,也就是說,患者也應該享有部分與之相關的權利,例如查看這些數據的權利。在法律訴訟案中,某個小孩出生的血液樣本被拿來進行研究,其母親表示:若研究人員來詢問她,她會同意的。人們普遍會同意,不過他們希望至少被告知並徵求過他們的意願。因此,若醫師要使用這些數據來進行特定用途,有必要進行「告知同意」。

另一個觀點則認為,從患者身上取得的數據,經過適當的處理之後並不能識別出特定病人的個人信息,特別是在數以千計的同類型數據當中,單筆數據並沒有特別的含意與價值(當然細胞系等較大的應用除外),且無法判定這組數據是來自哪個病人,因此在此情況下並不會涉及「個人隱私」。並且根據目前的法律規定,病患的醫療數據屬於衛生系統的財產,病患本身並無所有權。但雖然在患者握有的所有權本身沒有太多在法律上的論點,在倫理上卻是值得探討的。

所以總結以上,患者雖不擁有這些醫療檢測數據的所有權,但是醫師在使用這些數據時卻有告知病患的義務。除了以上所述的問題之外,還有另外一個比較積極的問題是:這些提供生理數據的患者是否享有部分學術或商業利益的權利?為了避免病患權利受損,此問題可能值得更進一步的思考與討論。

假資訊誤導

[编辑]人工智慧的發展,在影像及語音上的成果最豐碩,除了將影像中物體移除或移花接木、將模糊圖片清晰化之外,甚至可以在訓練過後,從無到有生成鳥類或花朵的圖片[7]。而最新的成果包含可以生成高畫質的風景照,例如Google就利用街景圖在世界各地所蒐集的資料,合成出令人屏息的專業風景圖[8]。然而這類的技術逐漸普及的同時,我們已可在各類的社群媒體上見到編輯過的假照片、影片,使得許多閱聽人信以為真。雖然要判斷影像是否為合成仍有跡可循,但乍看之下仍不好發覺而容易被誤導。如此的操作可能被用於製造假新聞、抹黑特定人物、甚至能左右重要選舉,造成的影響可能不止於個人,而很可能改變整個社會甚至政局的發展,絕對不容小覷。

參考資料

[编辑]- ↑ https://health.ettoday.net/news/1210503# ixzz5ZjxBStr2

- ↑ Kunz, M. A. (2017). Cloak: Remove unwanted objects in video. Adobe. https://research.adobe.com/news/cloak-remove-unwanted-objects-in-video/

- ↑ Rossion, Bruno; Hanseeuw, Bernard; Dricot, Laurence.Defining face perception areas in the human brain: A large-scale factorial fMRI face localizer analysis

- ↑ Wang, T. C., Zhu, J. Y., jiaxianhua, & Liu, M. Y. (July 4, 2019). NVIDIA/vid2vid: Pytorch implementation of our method for high-resolution (e.g. 2048x1024) photorealistic video-to-video translation. GitHub. https://github.com/NVIDIA/vid2vid

- ↑ Alarcon, N. (Jun 18, 2018). Transforming standard video into slow motion with AI. NVIDIA Developer. https://developer.nvidia.com/blog/transforming-standard-video-into-slow-motion-with-ai/

- ↑ Genkin, C., Pattani, M., Schuster, R., & Tromer, E. (Aug 21, 2018). Synesthesia: Detecting screen content via remote acoustic side channels. https://www.cs.tau.ac.il/~tromer/synesthesia/

- ↑ Tata, V. (Jan 11, 2018). Understanding and building generative adversarial networks(GANs)- deep learning with PyTorch. Medium. https://becominghuman.ai/understanding-and-building-generative-adversarial-networks-gans-8de7c1dc0e25

- ↑ Zhang, M. (Jul 14, 2017). Google uses AI to create professional photos from street view shots. PetaPixel. https://petapixel.com/2017/07/14/google-uses-ai-create-professional-photos-street-view-shots/